英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

基于角点定位和区域分割的多目标场景文本检测

摘要:

以往基于深度学习技术的场景文本检测方法大致可以分为两类。第一类将场景文本视为一种基本的对象,遵循一般的目标检测模式,通过回归文本框位置来实现场景文本的本地化, 但这一方法受场景文本的任意方向和较大的纵横比的干扰。第二种是直接对文本区域进行分割,但大多需要复杂的后处理。在本文中,我们提出了一种方法,结合了两种方法的思想,同时避免了它们的缺点。我们提出通过对文本边界框的角点定位和相关位置的文本区域分割来检测场景文本。在推理阶段,通过对角点进行采样和分组生成候选框,然后通过分割映射对候选框进行进一步划分,并通过 NMS 进行抑制。与以往的方法相比,该方法能够自然地处理长方向的文本,不需要复杂的后处理。在 ICDAR2013、ICDAR2015、MSRA-TD500、MLT 和 COCO- Text 上的实验表明,该算法在准确性和效率方面都取得了较好或有可比性的结果。基于 VGG16,在 ICDAR2015 上实现了 84:3% 的 F 值,在 MSRA-TD500 上实现了 81:5%的 F 值。

- 引言

近年来,随着现实应用需求的增长(如产品搜索[4]、图像检索[19]和自动驾驶),从自然场景图像中提取文本信息变得越来越流行。场景文本检测主要用于定位图像中的文本,在各种文本阅读系统中起着重要作用[34,10,47,5,20,13,7,25]。

由于外部和内部因素的影响,场景文本检测具有挑战性。外部因素主要来源于环境,如噪音,模糊和遮挡,这也是干扰一般目标检测的主要问题。内部因素是由场景文本的性质和变化引起的。与一般的目标检测相比,场景文本检测更加复杂,因为:1)场景文本可能存在于具有任意方向的自然图像中,因此边界框也可以旋转为矩形或四边形;2)场景文本边界框的高宽比差别很大;3)由于场景文本可以是字符、文字或文本行的形式,因此在定位边界时算法可能不适用。

在过去的几年中,场景文本检测得到了广泛的研究[10,5,49,20,43,52,39,42],并取得了明显的进展,一般目标检测和语义分割发展迅速。基于通用目标检测和语义分割模型,我们对文本进行了一些精心设计的修改,以便更准确地检测文本。这些场景文本检测器可以分为两个分支。第一个分支基于通用对象检测器(SSD[30]、YOLO[37]和DenseBox[18]),如TextBoxes[27]、FCRN[14]和EAST[53]等,它们直接预测候选边界框。第二个分支基于语义分段,如[52]和[50],它们生成分段映射并通过后处理生成最终的文本边界框。

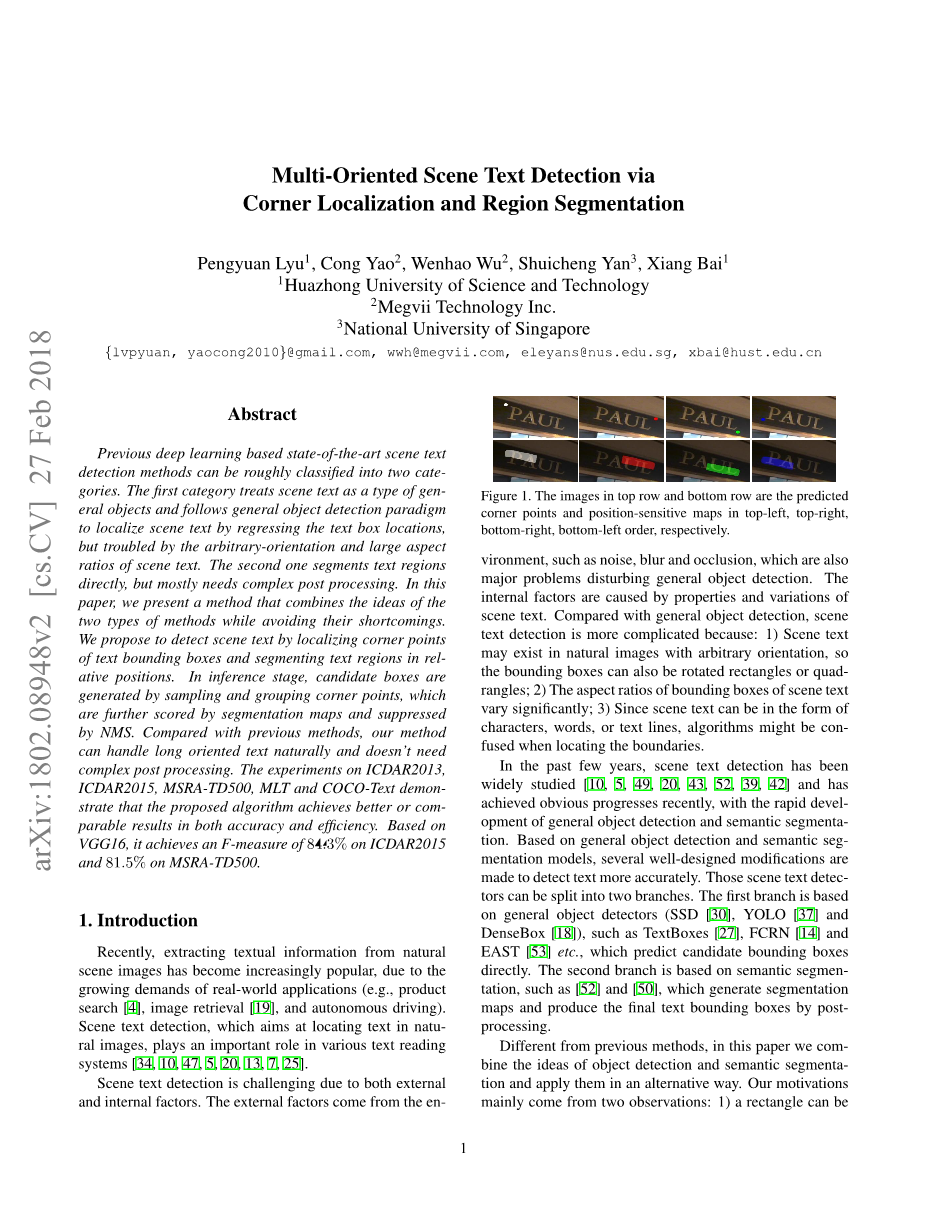

图1.上行和下行的图像按左上、右上、右下、左下顺序分别是预测的角点和位置敏感映射

与以往的研究方法不同,本文将目标检测和语义切分的思想进行了整合,并将其应用于语义切分的研究中。我们的动机主要来自两个方面:1)一个矩形可以是由角点决定,与矩形的大小、宽高比或方向无关;2)区域分割映射可以提供有效的文本位置信息。因此,我们首先检测文本区域的角点(左上角、右上角、右下角、左下角,如图 1 所示),而不是直接检测文本框。此外,我们预测位置敏感的分段映射(如图 1 所示),而不是文本/非文本映射,如[52] 和[50]。最后,通过对角点进行采样和分组,生成候选边界框,并利用分割信息剔除不合理的边界框。我们提出的方法流水线如图 2 所示。

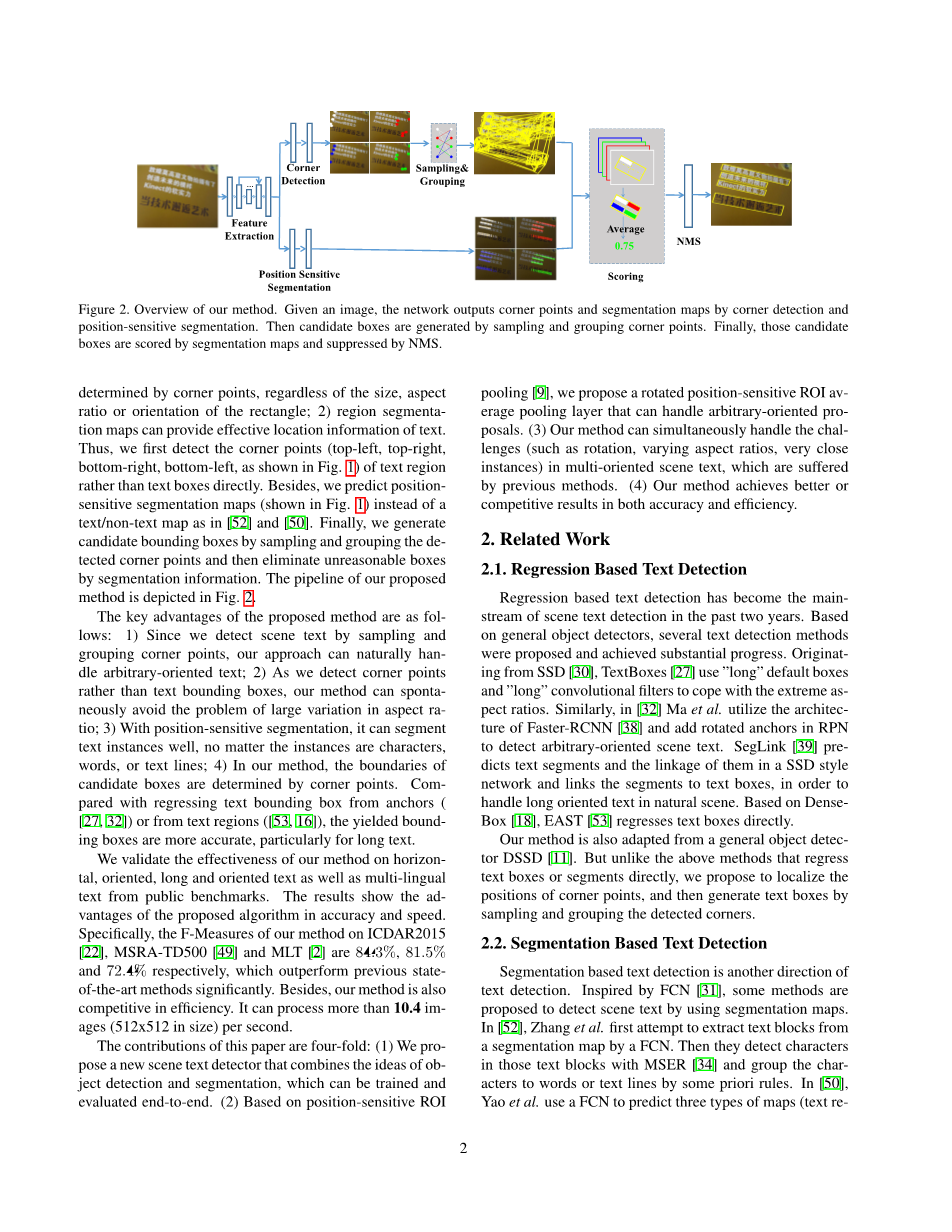

图2.我们的方法概述。给定一幅图像,网络通过角检测分割和位置敏感分割输出角点和分割图。然后通过采样和角点分组生 成候选框。最后,通过分段映射对候选框进行评分,并用 NMS 进行抑制。

该方法的主要优点:1)通过对角点进行采样和分组来检测场景文本,可以自然地处理任意方向的文本;2)由于我们检测的是角点而不是文本边界框,因此可以自动地避免方位变化大的问题;3)位置敏感的分割,可以很好地分割文本实例,不管实例是字符、单词还是文本行;4)在我们的方法中,候选框的边界由角点来确定。与从锚([27,32])或从文本区域([53,16])返回文本边界框相比,已生成的边界框更准确,特别是对于长文本。

通过对公共基准测试数据的分析,验证了本文方法的有效性,包括横向的、对面向的、长对象的的文本以及多语言文本。实验结果表明,该算法在准确性和速度上都具有优势。 具体来说,我们的方法在 ICDAR2015[22],MSRA- TD500[49]和 MLT[2]上的 F 值分别为 84:3%,81:5%和 72:4%,明显优于先前的最新方法。此外,我们的方法在效率上也是有竞争力的。它可以每秒处理超过 10.4im- ages(512x512 大小)。

本文的贡献有四个方面:(1)提出了一种新的场景文本检测器,它结合了对象检测和分割的思想,可以进行端到端的训练和评估。(2)基于位置敏感的 ROI池[9],我们提出了一种旋转位置敏感的 ROI 视频池层,它可以处理任意方向的视频。(3)该方法可以同时处理多方向场景文本中存在的旋转、变长宽比、非常接近的实例等延长问题。(4)我们的方法在准确性和效率方面都取得了较好的结果。

- 相关工作

2.1.基于回归的文本检测

基于回归的文本检测已经成为近两年来场景文本检测的主流技术。在通用目标检测器的基础上,提出了几种文本检测方法,并取得了实质性进展。源自 SSD[30],TextBoxes[27]使用“长” 默认框和“长”卷积过滤器来处理极端的作为完美比例。类似地, 在[32]Ma 等人利用 Faster-RCNN[38]的框架结构,在 RPN 中添加旋转锚来检测任意面向的场景文本。Seglink[39]预判文本片段和它们在 SSD 风格的网络中的联系,并将片段链接到文本框,以便在自然场景中处理长方向的文本。基于稠密框[18], EAST[53]直接回退文本框。

我们的方法也适用于一般的对象检测器 DSSD[11]。但是,与上述直接回归文本框或片段的方法不同,我们提出将角点的位置定位,然后通过对检测到的角点进行采样和分组来生成文本框。

2.2.基于分割的文本检测

基于分割的文本检测是文本检测的另一个发展方向。受 FCN[31]的启发,提出了利用分割图检测场景文本的方法。在[52]中,Zhang 等人首次尝试通过 FCN 从分段映射中提取文本块。然后他们用 MSER[34]检测那些文本块中的字符,并根据一些先验规则将字符分组为单词或文本行。在[50]中,姚等人使用一个 FCN 来预测三种类型的地图动画,字符和连接方向)的输入即时信息。然后对分割图进行后处理,得到文本包围盒。

与以往基于分割的文本检测方法不同,该方法通常需要进行复杂的后处理。在推断阶段,利用位置敏感的分割图,通过我们提出的旋转位置敏感的平均感兴趣区域集合层对候选框进行评分。

2.3.基于角点的通用目标检测

基于角点的通用目标检测方法是一种新的通用目标检测方法。在 DeNetTychsen-Smith 等人提出了一个角点检测层和一个稀疏采样层来代替快速 rcnn 风格的两阶段模型中的 RPN。在[48]中,Wang 等人提出了 PLN ( Point Linking Network 点连接网络),它利用完全卷积网络回溯边界框的角点/中心点及其连接点。 然后使用角点/中心点及其链接形成对象的边界框。

我们的方法的灵感来自于那些基于角点的对象检测方法,但是它们之间存在关键的区别。首先,我们的方法的角检测器是不同的。其次,我们使用分割映射对候选框进行评分。第三,它可以生成任意面向对象的方框(文本)。

2.4.位置敏感型分割

近年来,人们提出了基于位置敏感地图的实例感知语义分割方法。在[8]中,Dai 等人首先介绍了相对位置的分割和 支持 InstanceFCN 的实例段建议。在 FCIS[26]中,李等人提出了一种端到端网络的实例感知语义分割方法。

我们还采用位置敏感的分割图来预测文本区域。与上述方法相比,有三个关键区别: 1) 我们直接使用位置敏感的地面真值(在第 4.1.1 节中去尾)优化网络; 2) 我们的位置敏感地图可以用于预测文本区域和同时给方案评分(详见第 4.2.2 节),不同于 FCIS 使用两种类型的位置敏感地图(内部和外部);3)我们提出的位置 敏感 ROI 汇集可以处理任意导向的方案。

- 网络

该方法的网络是一个完全卷积的网络,起着特征提取、角点检测和位置敏感分割的作用。网络结构如图 3 所示。给定一幅图像,该网络生成候选角点和分割图。

3.1.特征提取

我们的模型的主干是改编自一个预先训练的 VGG16[41] 网络,并设计了以下内容:1)场景文本的大小变化巨大,所以主干必须有足够的能力来处理这个问题;2)自然场景的背景是复杂的,所以特征应该更好地包含更多的上下文。受到 FPN[28]和 DSSD[11]在这些问题上取得的良好性能的启发, 我们采用 FPN/DSSD 架构中的骨干网来提取特征。

在细节上,我们将 VGG16 中的 fc6 和 fc7 转换成卷积层,分别命名为卷积层和卷积层。然后将多个额外的卷积层(卷积层 8、卷积层 9、卷积层 10、卷积层 11)叠加在卷积层上,扩大了特征的感受域。然后,在一个自顶向下的通路中使用 DSSD[11] 中提出的几个解卷积模块(图 3)。为了更好地对不同尺寸的文本进行解卷积,我们建立了从卷积 11 到卷积 3 共 256 个通道的级联解卷积模块(重用了卷积 10、卷积 9、卷积 8、卷积 7、卷积 4、 卷积 3 的特性),并总共建立了 6 个解卷积模块。结合 11 的特 点,我们将这些输出特性命名为 F3、F4、F7、F8、F9、F10 和 F11。最后,利用卷积和反卷积模块提取的特征进行角点检 测和位置敏感地图预测。

3.2.角检测

对于一个给定的矩形边界框 R = ( x,y,w,h,theta;),四个角点(左上、右上、右下、左下)可以用直角坐标系表示成{(x1, y1), (x2, y2), (x3, y3), (x4, y4)}。为了方 便地检测角点,我们用一个水平正方形重新定义和表示一个 角点(Xc,Yc,ss,ss),其中 Xc;Yc 是角点的坐标(如 x1;y1 表示左 上角点)以及水平方块的中心。ss 是旋转矩形边界框 R 的短边。

在 SSD 和 DSSD 之后,我们用缺省框检测角点。与 SSD 或 DSSD 中每个默认方框输出相应候选方框的分类得分和偏移量的方式不同,角点检测更为复杂,因为在同一位置可能有多个角点(例如一个位置可能同时是两个方框的左下角和右上角)。所以在我们的例子中,一个默认的框应该输出对应于 4 种类型的 角点的 4 个候选框的分类得分和偏移量。

我们采用[11]中提出的预测模块,以卷积的方式预测两个分支中的分数和偏移量。为了降低计算复杂度,将所有卷积滤波器设置为256。在每个 mtimes; n特征映射 k 个缺省框的单元格中,“分数”分支和“偏移 量”分支输出 2 个分数和 4 个偏移量重新专门为每种类型的角点的每个缺省框。在这里,2 表示“score”分支,意味着这个位置是否存在一个角点。总的来说,“score”分支和 “offset”分支的输出通道是 k times; q times; 2 和 k times; q times; 4,其中 q 表示角点 的类型。默认情况下,q 为 4。

在训练阶段,我们遵循了SSD中默认方框和背景真实方框的匹配策略。为了检测不同大小的场景文本,我们在多层特征上使用多个大小的默认框。表中列出了所有默认框的长宽比,默认盒的长宽比设置为 1。

图3. 网络架构。该网络由主干网、角点检测器和位置敏感分割预测器三部分组成。主干是改编自DSSD[11]。角点检测器建立在多个特征层(粉红色快)。位置敏感的分割检测器与角点检测器共享一些特征(粉红色快)。

3.3.位置敏感型分割

在已有的基于分割的文本检测方法[52,50]中,生成一个分割映射来重新发送每个像素属于文本区域的概率。然而,由于文本区域的重叠和文本像素的不准确预测,得分图中的文本区域往往不能相互分离。为了从分割图中得到文本边界框,在 [52,50]中进行了复杂的后处理。

受 InstanceFCN[8]的启发,我们使用位置敏感的分割来生成文本分割图。与以往的文本分割方法相比,生成了相应的分割条件。具体来说,对于一个文本边界框 R ,一个g times; g 规则网格被用来将文本边界框划分为多个容器(例如,对于一个 2times;2 的网格,一个文本区域可以划分为 4 个容器,即左上方、右 上方、右下方和左下方)。对于每个容器,使用一个分段映射4确定这个地图中的像素是否属于这个箱子。

在统一的网络中构建了基于角点检测的位置敏感分割算法。我们重复使用了 F3、F4、F7、F8、F9 的特性,并按照角点检测分支的残留块结构在上面构建了一些卷积块(如图 3 所示)。通过在边界上进行抽样,将各块的产量分别调整为 1,2,4,8,16 的比例系数,从而得到 F3 的比例尺。然后将所有具有相同规模的输出集合在一起,生成更丰富的特性。进一步通过两个连续的Conv1x1-BN-ReLU-Deconv2x2 块来提高融合特征的分辨率, 并将最后一个反卷积层的核设置为 gtimes;g,使得最终的位置敏感分割图具有 gtimes;g 通道和相同的大小。在这个工作中,我们默认将 g 设置为 2。

- 训练和推理

4.1.训练

表1. 不同涂层上默认框的比例

图4.基于焦点检测和位置敏感分割的标签生成算法

- 角点重新被定义,并用正方形(白色、红色、绿色、蓝色)的方框表示,边长设置为文本包围框R的短边

-

第(a)项用于位置敏感分割的R的对应基本真理<!--

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[237139],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。

您可能感兴趣的文章

- 为非政府组织OG慈善基金会设计的基于社区的救灾管理系统外文翻译资料

- 基于UML建模的医疗系统电子健康服务软件外文翻译资料

- 开发一种具有增强现实功能的智能手机应用程序, 以支持护理学生对心衰的虚拟学习外文翻译资料

- 在开发 Web 应用程序中应用 Vue.JS 框架外文翻译资料

- 基于MES系统的生产车间信息管理研究外文翻译资料

- 基于Vue.js和MySQL的电子商务平台的设计与实现外文翻译资料

- 详细的Spring配置和SpringBoot外文翻译资料

- 基于NS2的DSR和AODV协议的性能比较研究外文翻译资料

- 不同仿真参数下NS2的TCP吞吐量性能外文翻译资料

- 基于Spring Boot和VUE的车辆管理系统实现外文翻译资料