英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

决策树:Introduction

决策树是用于分类和预测以及促进顺序决策问题中的决策的有效方法。本条目详细考虑了三种类型的决策树。第一种是基于信息节点序列的推荐行动方案的算法;第二是分类和回归树;第三是生存树。

决策树

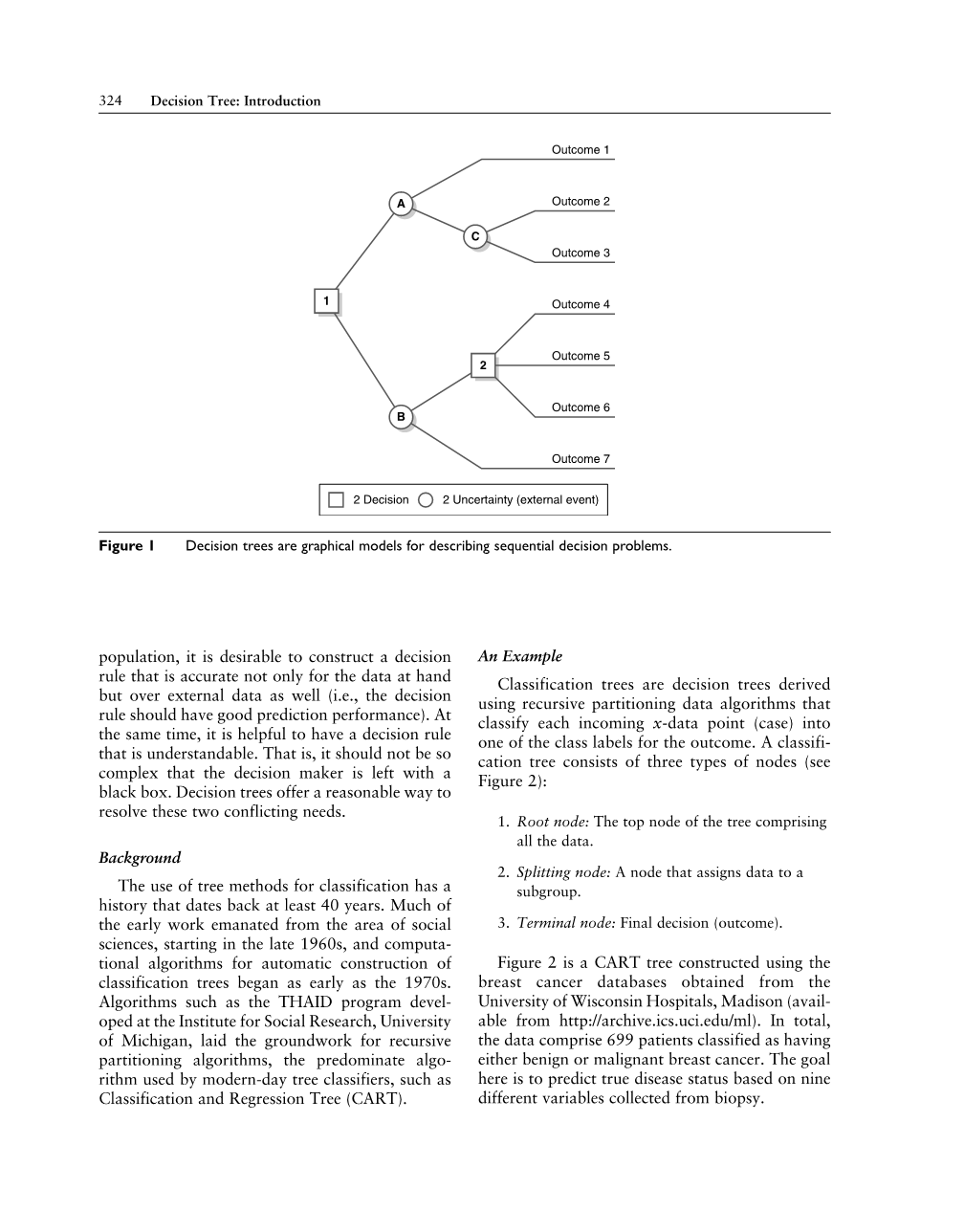

通常,医疗决策者将面临顺序决策问题,该问题涉及根据机会导致不同结果的决策。如果决策过程涉及许多顺序决策,则决策问题变得难以可视化和实施。决策树是此类设置中不可或缺的图形工具。它们允许直观地理解问题,并有助于决策。决策树是描述决策及其可能结果的图形模型。决策树由三种类型的节点组成(参见图1):

- 决策节点:通常由显示可以做出的决策的方块表示。从正方形发出的线显示节点上可用的所有不同选项。

- 机会节点:通常由显示机会结果的圆圈表示。机会结果是可能发生但不在决策者控制能力之外的事件。

- 终端节点:通常由三角形或没有其他决策节点或机会节点的线表示。终端节点描述了决策过程的最终结果。

例如,一家为食管癌患者进行食管手术(手术切除全部或部分食管)的医院希望根据手术切除的区域淋巴结总数确定适当的淋巴结切除术的方案. .医院认为这样的方案应该由病理学指导(外科医生在手术前可用)。这些信息应包括

组织病理细胞类型(鳞状细胞癌或腺癌);组织病理学分级(肿瘤生物学的粗略指标);和肿瘤浸润深度(PT分类)。据信,当组织病理学分级差异较大且节点数量因细胞类型不同时,待移除的节点数量应随着侵入性更强的肿瘤而增加。

在这种情况下,决策树主要由机会结果组成,这些结果来自病理学(细胞类型,等级和肿瘤深度)。外科医生唯一的决定是是否进行食管切除术。如果决定操作,则外科医生在图表上遵循该决策线,从左向右移动,使用病理数据最终确定终端节点。终端节点或最终结果是要移除的淋巴结的数量。

在某些情况下,决策树可用于做出最佳决策。为此,必须为决策树中的终端节点分配终端值(有时称为支付值或终点值)。例如,一种方法是为每个决策分支和机会分支分配值,并将终端值定义为通向它的分支值的总和。分配终端值后,通过从右到左的终端值计算树值。计算机会结果的值,乘以它们的概率。机会节点的总和是这些值的总和。要确定决策节点的值,将从已计算的成本中减去每个决策线上每个选项的成本。该值代表决策的好处。

分类树

在许多医疗环境中,医疗决策者可能不知道决策规则是什么。相反,他或她想通过使用数据来发现决策规则。在这样的设置中,决策树通常被称为分类树。分类树适用于y值(结果)是分类标签的数据,例如患者的疾病状态,医疗决策者希望构建一个使用x变量预测结果的决策规则(因变量) )数据中可用。因为可用的数据集只是底层的一个样本

结果1

A

结果2

C

结果3

1

结果4

2

结果5

B

结果6

结果7

2决定 2不确定性(外部事件)

图1 决策树是用于描述顺序决策问题的图形模型。

在人口中,期望构建一个决策规则,该决策规则不仅对于手头的数据而且对于外部数据也是准确的(即,决策规则应该具有良好的预测性能)。同时,有一个可以理解的决策规则是有帮助的。也就是说,决策者留下一个黑盒子应该不会那么复杂。决策树提供了一种合理的方法来解决这两个相互冲突的需求。

背景

使用树方法进行分类的历史至少可以追溯到40年前。从20世纪60年代末开始,大部分早期工作都来自社会科学领域,早在20世纪70年代就开始了自动构建分类树的计算算法。诸如密歇根大学社会研究所开发的THAID程序等算法为递归分割算法奠定了基础,递归分割算法是现代树分类器使用的主要算法,例如分类和回归树(CART)。

一个例子

分类树是使用递归分区数据算法导出的决策树,该算法将每个传入的x数据点(大小写)分类为结果的类标签之一。分类树由三种类型的节点组成(参见图2):

- 根节点:包含所有数据的树的顶部节点。

- 拆分节点:将数据分配给子组的节点。

- 终端节点:最终决定(结果)。

图2是使用从威斯康星大学医院麦迪逊分校获得的乳腺癌数据库构建的CART树(可从http://archive.ics.uci.edu/ml). 总的来说,该数据包括699名被分类为患有良性或恶性乳腺癌的患者。这里的目标是根据从活组织检查中收集的九个不同变量来预测真实的疾病状态。

尺寸<2.5 尺寸>=2

细胞=1,2,3,4,5,?

核10、6、7、8

良性 458/241

不成形<2.5

不成形>=2.5

良性417/12

发生丛<5.5

发生丛>=5.5

恶性41/229

细胞核=1,2,?

核=10,3,4,5,6,7,8,9

良性416/5

恶性1/7

良性18/5

不成形3.5

恶性23/224

不成形3.5

良性18/1

恶性0/4

恶性13/23

恶性10/201

良性7/0

恶性6/23

图2 威斯康星州乳腺癌数据的分类树

注意:浅色阴影和深阴影条形图显示两个类别的每个节点的数据频率:良性(浅色阴影);恶性(深色阴影)。终端节点通过多数表决进行分类(即,对具有最大频率的类标签进行分配)。在拆分节点上方给出的黑色标签显示了如何根据给定变量拆分数据。在某些情况下,缺少数据,由问号表示。

树的第一次分割(在根节点处)在变量“unsize”上,测量单元大小的均匀性。对于该变量,值小于2.5的所有患者被分配到左侧节点(左侧子节点);否则它们被分配到右侧节点(右侧子节点)。然后分割左右子节点(在这种情况下,对于右子节点的变量“unshape”和对于左子节点的变量“nuclei”),并且将患者分配给由这些分割定义的子组。然后拆分这些节点,并在称为递归分区的过程中递归地重复该过程。当树

构造完成后,终端节点通过多数表决(具有最大频率的类标签)分配类标签。给定终端节点中的每个患者分配该终端节点的预测类标签。例如,图2中最左边的终端节点被分配了类标签“良性”,因为节点中421个案例中的416个具有该标签。从图2中可以看出,对于所有终端节点,投票大大偏爱一个类而不是另一个类,这表明决策树正在准确地对数据进行分类。但是,使用外部数据集或使用交叉验证来评估准确性非常重要。

递归分区

通常,递归分区的工作原理如下。分类树从根节点开始生长,根节点是树的顶部节点,包括所有数据。根节点分为两个子节点:左子节点和右子节点。反过来,每个子节点被分开,每个分裂产生左右两个女儿。以递归方式重复该过程,直到由于缺少数据或者达不到一些停止标准而不能进一步分割树,导致终端节点的集合。终端节点将预测器空间的分区表示为不重叠的矩形区域的集合。然而,应该注意,该分区可能与通过穷举搜索对应于相同数量的终端节点的所有分区而发现的分区完全不同。然而,对于许多问题,对全局最优分区的详尽搜索(在产生最均匀叶子的意义上)在计算上是不可行的,并且递归分区代表了通过使用一步过程来执行该任务的有效方式。

如上所述的分类树被称为二进制递归分区树。另一种递归分区树是多路递归分区树。这些树不是将父节点分成两个子节点,而是使用定义多个子节点的多路分裂。然而,几乎没有证据表明多路分裂产生更好的分类器,因此,为了简单起见,二进制递归分区树通常是受欢迎的。

拆分规则

CART作为分类器的成功很大程度上归因于在树结构中形成分裂的方式。为了定义良好的分裂,CART使用杂质函数来测量分裂的树杂质的减少。树的纯度衡量叶子中相似的观察结果。通过搜索所有可能的变量和所有可能的分割值并选择最能减少杂质的变量和分割,可以找到节点的最佳分割。减少树木杂质是一个很好的原则,因为它鼓励树木将不同的情况分开。最终,作为节点的数量

增加,不同的情况分成子节点,树中的每个节点变得同质,并由具有相似结果的情况填充(回想图2)。

使用了几种杂质功能。这些包括二元标准,熵标准和基尼系数。基尼指数可以说是最受欢迎的。当结果有两个类标签(所谓的两类问题)时,如果类标签被重新编码为0和1,则gini索引对应于结果的方差。

停止规则

树的大小对分类器的准确性至关重要。如果树太浅,终端节点将不纯(结果将是异构的),并且分类器的准确性将受到影响。如果树太深(分裂太多),则终端节点内的情况数量将很小,并且预测的类别标签将具有高方差 - 再次破坏分类器的准确性。

为了达到适当的平衡,在诸如CART之类的方法中采用修剪。为了确定树的最佳大小,树生长到完整大小(即,直到所有数据都被花费),然后修剪回来。使用复杂性度量来确定最佳大小,该度量平衡了通过成本复杂度和树的大小测量的树的准确性。

回归树

当y结果是连续测量(例如年龄,血压,心脏射血分数等)时,决策树也可用于分析数据。这种树称为回归树。可以使用类似于分类树的递归分区来构造回归树。使用均方误差测量杂质。回归树中的终端节点值被定义为终端节点内患者的结果的平均值(平均值)。这是结果的预测值。

生存树

在医学科学中经常遇到事件时间数据。对于这样的数据,分析

重点是了解如何根据可能为患者收集的不同变量来改变事件的时间。事件发生的时间可以是某种疾病的死亡时间,复发时间(癌症),首次出现症状的时间,或简单的全因死亡率。

由于存在审查,对事件发生时间数据的分析通常很复杂。一般而言,这意味着研究中某些个体的事件时间未被准确地观察到,并且仅在某些时间间隔内被知道。正确审查是遇到的最常见的审查类型之一。只有在某个预定时间之前发生感兴趣事件时才会发生这种情况。例如,可以监测患者2周

没有出现症状然后从医院出院。据说这样的患者受到了正确的审查,因为事件发生的时间必须超过2周,但确切的事件时间是未知的。当患者在不同时间进入研究并且预定研究结束一定时间时,发生右检查的另一个例子。然后,在研究期间未经历事件的所有患者都被正确审查。

决策树可用于分析右删失的生存数据。这种树被称为生存树。可以使用递归分区来构建生存树。与CART一样,杂质的测量起着关键作用,这可以通过多种方式来定义。一种流行的方法是

1

NKI70

p .007

0

0

3

茶匙

p .298

1

1

节点2(n =44)

1

节点4(n =22)

1

节点5(n = 44)

1

.8 .8 .8

.6 .6 .6

.4 .4 .4

.2 .2 .2

0

0 5 10 15 20

0

0 5 10 15 20

0

0 5 10 15 20

图3 乳腺癌患者的二元存活树

注意:因变量NKI70和TSP是基因签名。例如,极右的终端节点(节点5)对应于NKI70和TSP基因签名的存在。在每个终端节点下面是该节点内患者的Kaplan-Meier生存曲线。

328 决策树,构建中的先进技术

使用对数秩检验定义杂质。与在CART中一样,通过减少杂质来生长树确保终端节点由具有相似行为的个体填充。在存活树的情况下,终端节点由具有相似存活率的患者组成。生存树中的终端节点值是生存函数,并且使用终端节点内的那些患者来估计。这与分类和回归树不同,其中终端节点值是单个值(分别是响应的估计类标签或预测值)。图3显示了生存树的一个例子。

Hemant Ishwaran和J. Sunil Rao

另见决策树,构造中的高级技术;递归分区

深入阅读

Breiman, L., Friedman, JH, Olshen, RA, amp; Stone,

CJ(1984)。分类和回归树。贝尔蒙特,加利福尼亚州:沃兹沃思。

LeBlanc,M。,

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[20436],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。