英语原文共 46 页,剩余内容已隐藏,支付完成后下载完整资料

卷积神经网络的独立特征识别

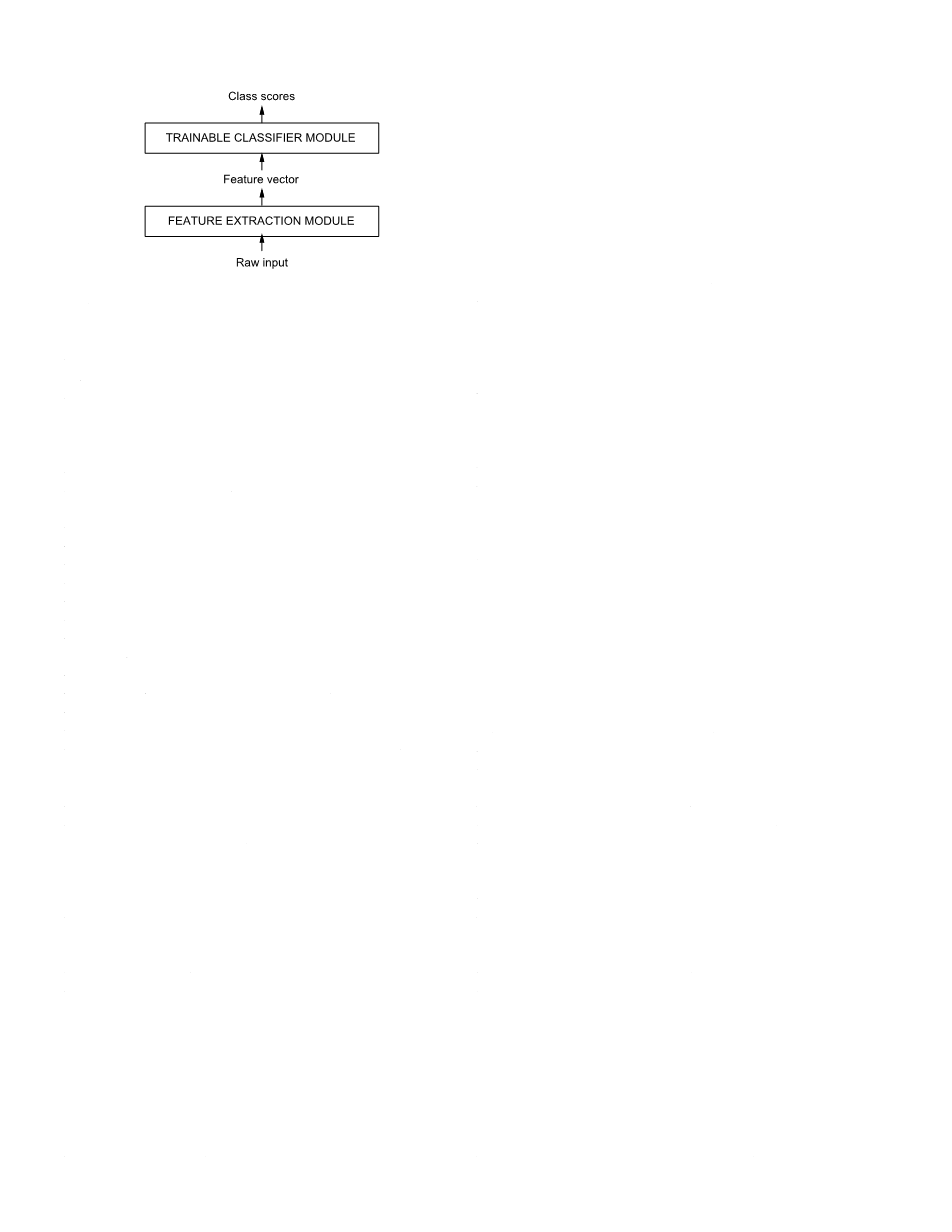

使用梯度下降算法训练的多层网络能够从大量数据集中学习复杂、高维度且非线性的模型,这使得他成为图像识别任务的首选。在传统的模式识别模型中一个人工设计的特征提取器从输入收集相关信息,并消除无关的因子然后一个可训练的分类器通过特征向量进行分类。针对这种情况,标准的全连接多层网络可以用作分类器,更有趣的是方案是依靠尽可能增加特征提取器来提高识别精度。阿紫特征识别的问题中,可以将一个图像按像素表示成一个向量,直接输入到网络中。一些成功的例子,例如特征识别,已经说明全连接前馈网络可以完成此类任务,但是仍然存在一些问题。

首先,通常图像的数据量非常达,一般有几百像素一个全连接网络的第一层隐含层要与这个图像的数据量在同一数量级,也要有几百个单元,这会导致第一个隐含层与输入层的全连接有数万个连接权值。如此大的量级会导致对系统容量的需求增加,同时需要更达的训练数据集。在某些条件下,这种来存储如此多的权值的内存需求会破坏硬件系统的实现。但是对于图像或者音频的非结构化网络的主要缺陷在于他们没有对于输入的平移或局部扭曲的内院不变性。特征图像或其它二维、一维信号在输入到固定大小的输入层之前必须进行归一化和中心化。不幸的是,不存在这样的预处理过程可以达到完美的效果。手写字体是单词水平用来归一化的目标。会出现大小,倾斜和位置等各种各样的变化,这将导致在不同的位置出现不同的特征。原则上,全连接网络可以足够应对这些变化,来应对无论输入出现在什么位置都能够正常的工作。但是,这种学习任务需要大量的数据集,要求数据集能够覆盖各种情况。在接下来的描述中将会看到,卷积神经网络通过共享权值来自动地获得了平移不变性。

其次,全连接结构还有一个缺点就是输入数据的拓扑结构是被无视的输入数据可以以任何顺序输入而不会影响到训练的结果。相反的,图片或者时间序列的音频具有天生的强二维结构,空间或时间上相邻的变量是强相关的。在识别时间或空间对象前,提取并连接局部特征的有点是众所周知的,因为局部相关性必须要在考虑范围之内,局部的输入数据可以被提取为局部特征,如边、角等,卷积神经网络能够通过限制隐藏单元的感受野大小提取这种局部特征。

卷积神经网络

卷积神经网络由三种结构组成来确定物体的平移、缩放和失真的不变性。三种结构分别是:局部感受野、共享权值和基于事件或空间的局部抽样。典型的由于特征识别的卷积神经网络如图2所示。这个网络被称为LeNet-5。输入层接受经过适当归一化和中心化的图片。层中的每一个单元的输入是上一层的一个小且局部相邻的单元输出。这种输入来自于局部感受野的思路最早可以追溯到上世纪60年代早期的感知器,这种具有局部敏感、方向选择性的神经元并且几乎被Hubel和Wiesel同时在猫的视觉系统中发现。局部连接已经被用在许多视觉学习神经元模型中。由于局部感受野的存在,这种神经元能够提取初级的视觉特征,例如某一方向的边、终点、弯角(或在其他信号中,比如音频信号中的图谱)。然后这些特征被下一层连接起来以提取出更高级的特征。如前所述,输入的扭曲或位移可能会导致重要特征的位置变化。另外,初级特征提取器如果对图片的某一部分起作用,那么很可能对整个图片都有效。通过这一点,可以让一组感受野在不同位置上单元具有相同的权值。这样在一层中的单元可以组织成一个平面,在这个平面中的所有单元共享相同的权值,这个平面的单元得到的输出称为特征图。如此一来,一个特征图上的单元就是在图像上各个部分进行相同的计算行为。一个完整的卷积层便由若干个这样的特征图组成(每一个特征图有不同的权值向量),这样每一个部分就可以并提取出多个特征。图2中所示的LeNet-5的第一层就是一个具体的例子。LeNet-5的第一个隐含层被组织成6个平面,每一个代表一张特征图。特征图的一个单元被连接到输入上一个5times;5的区域,这个区域便是此单元的感受野。每个单元总共有25个输入,因此每个单元有25个可训练的权值和1个可训练的偏移量。一张特征图上相邻单元的感受野与前一层的相邻单元相对应。因此,相邻单元的感受野是彼此重叠的。例如,在LeNet-5的第一个隐藏层中,水平相邻单元的感受野存在大小为4列5行的重叠。如前所述,一张特征图上的所有单元共享25个相同的权值和1个相同的偏置量,他们在输入上对每一个可能的位置进行特征提取。而另一特征图则使用另一组权值和偏置,从而提取不一样的特征。在LeNet-5中,一共有六个特征图,每一特征图上相同位置的单元从输入图像的每一个位置提取6个不同的特征。一个特征图的组成也可以看作使用一个带有局部感受野的单元对输入图像的每一个位置进行扫描,然后按照位置关系将输出在特征图上进行存储。这种操作与数学上的卷积相似,除了附带一个偏置量和阈值函数,因此称作卷积网络。卷积的核就是特征图的单元使用的一组连接权值。卷积层的一个有趣属性是如果输入的图像发生了位移,那么输出的特征图也会发生相同的位移,但是其他特征不会改变。这个属性是卷积网络对于输入的位移或失真的鲁棒性。

一旦一个特征被检测出来,它的精确位置就变得不那么重要了。只有它相对于其他特征的大概位置才是有关系的。例如,一旦我们知道了输入图像在左上方区域有一个大致水平段的端点,右上方区域有一个角点,同时图像的下方区域有一个大概垂直段的端点,我们就可以辨别出输入图像是数字7。对于模式识别来说,不仅是这些特征的精确位置不相关,由于各种特征的实际位置也在改变,考虑这种精确的位置关系可能有害而无益。为了减少在一个特征图中编码的不同特征的精确位置,一种简单可行的方式就是减少特征图的分辨率。这一点通过子抽样层来实现,子抽样层通过计算局部均值来实现特征图的分辨率降低,同时可以降低输出对于位移、失真的敏感性。LeNet-5的第二个隐藏层便是一个子抽样层。这一层将前一层输出的六个特征图进行压缩。每一个单元的感受野是前一层的特征图上的一个2times;2的区域,每一个单元计算这个四个输入的平均值,乘以一个可训练的系数,再加上一个可训练的偏置量,最后经过一个sigmoid函数得到输出的结果。相邻的单元不存在彼此覆盖的感受野。因此,一个子抽样层得到的特征图长与宽分别是前一层特征图的一半。可训练的系数和偏置量控制着sigmoid函数的非线性作用。如果系数很小,那么单元工作在拟线性模式,子抽样层近似是对输入的模糊。如果系数很大,子抽样层可以被看作是受偏置量影响的noisy OR或noisy AND函数。卷积层与子抽样层这种结构通常连续的交替使用。特征图的数量会逐渐增加同时特征图的分辨率会逐渐减少。图2中的第三个隐藏层中每一个单元与前一层的若干个特征图相连。这种卷积-子抽样的组合来自于Hubel与Wiesel的简化与复杂化的概念,被福岛的Neocognitron实现出来,虽然那个时候没有例如反向传播这种可靠的监督学习过程。对几何变换的不变性通过空间分辨率的逐级递减和特征图的逐级增加来实现的。

由于所有的权值都是通过反向传播学习了,卷积网络能够被看作是合成自己的特征提取器。得益于权值共享技术,网络的自由变量有效的减少,因此对机器的容量减少了,同时也降低了训练误差和测试误差之间的距离。图2所示的网络包含340908个连接,但由于权值共享,只有60000个可训练的自由参数。

固定大小的卷积网络已经再手写数字识别、打印字符识别和人脸识别领域得到广泛的应用,固定大小卷积网络再单一时间维度上进行卷积就是时延神经网络。时延神经网络已经被用于音素识别、单词识别、孤立手写字符的在线识别和签名认证等。

LeNet-5

这一节将更加详细地描述LeNet-5网络地整个结构。除了输入层、LeNet-5一共由7层组成。每一层都包含可训练的参数(权值)。输入图像大小为32times;32像素,数据集中都是28times;28的图像,这比数据集中最大的图片还要大,原因是这样做可以将像边、角这样潜在的特征再高层的特征图中出现再感受野的中心。再LeNet-5中,输入像素的值都经过归一化,这样,-0.1代表背景颜色,1.175代表前景颜色。这使得输入图像的均值为0,方差接近1,可以达到加速学习的效果。

在接下来的讨论中,卷积层使用Cx表示,子抽样层使用Sx表示,全连接层使用Fx表示,其中x代表第几层。

C1层是一个卷积层,具有6个特征图。每一个特征图上的每一单元与一个5times;5的输入邻域相连。为了防止卷积核超出输入图像的范围,特征图的大小是28times;28。C1层包含156个可训练的参数和122304个连接。

S2层是一个子抽样层,具有6个大小为14times;14的特征图。每个特征图的每个单元与对应的C1层中特征图的2times;2邻域相连。4个输入相加,乘以一个可训练的系数,最后加上一个可训练的偏置量,结果经过一个阈值函数即为输出。2times;2的感受野是不相互重叠的,因此S2中的特征图的宽高是C1中的一半。S2层具有12个可训练的参数和5880个连接。

C3层是一个有16个特征图的卷积层。每一个特征图上的每一单元与S2中若干个5times;5的输入邻域相连。表1展示了S2中的特征图与C3层相连的关系。为什么C3不与S2的每一个特征图相连?原因有两点,首先,非全连接方案保证了适当的连接数更重要的是,打破网络的对称性。由于这种划分,不同的特征图被规定从不同的特征中进行提取。表1所列的连接方案原理如下:C3中的前6个特征图从S2中中选3个特征图作为彼此不相同的输入子集,接下来的六张图从S2中选择4个特征图作为彼此不相同的输入子集。接下来的三张图从S2中选择4个不相连的特征图作为输入。最后一个图使用全连接方案。C3层共有1516个可训练参数,151600个连接。

S4是一个大小为5times;5的子抽样层,具有16个特征图,类似S2与C1之间的连接方式,每个特征图的每个单元与对应的C3层中特征图的2times;2邻域相连。S4层具有2个可训练的参数和2000个连接。

C5层是一个具有120个特征图的卷积层。每一个单元与S4中的16个特征图上的5times;5邻域相连。由于S4中的特征图大小也是5times;5,所以C5的特征图大小仅为1times;1,这也是可以看作是S4和C5之间的全连接层。C5被标记为一个卷积层而不是全连接层是因为如果LeNet-5的输入图像更大,C5层的结果将不再是1times;1关于卷积网络输入的大小动态增长将在第七节进行描述。C5层共有48120个可训练的连接。

F6层是一个全连接层,有84个单元,与C5层进行全连接。有10164个可训练的参数。

在经典的神经网络中,全连接层的单元计算输入向量和自身的权值向量(单元i的权值向量标记为ai)的点积,再加上一个偏置量,经过一个激活函数,得到的结果就是单元的状态,标记为xi

激活函数是带有系数的双曲正切函数:

其中A是函数的增幅系数,S决定激活函数的倾斜度。函数f是一个偶函数,在纵轴上有最大值 A和最小值-A。常数A被设置为1.7159。常数的选择原理会在附录A中给出。

最后,输出层使用欧几里得径向基函数(RBF)与84个单元相连,每一个输出单元代表一类结果。每一个RBF单元yi的计算过程如下:

换句话说,每一个RBF单元计算输入向量与参数向量的欧几里得距离。RBF单元的输出越大,输入与参数向量就相差更远。一个特定的RBF单元输出可以理解为输入模式与RBF相关联的类模式的匹配度量。在概率学中,RBF单元的输出可以被看作是F6层空间高斯分布中一个非归一化的负对数似然概率。给定一个输入模式,损失函数的功能设计应该使得F6的功能配置尽可能的接近RBF的参数向量,从而符合模式对应的类。这些单元的参数向量是手动选择的,并且保持不变(至少在最初)。参数向量的每部分设定为-1或 1。然而他们应该被等概率的选择为-1或 1,或者构造一种误差修正代码像文献[47]中所示。他们用7ⅹ12的特征类位图来代替一个程序化的图。这样的代替不是很有用对于孤立的数字而言,但是它是非常有用的对于一连串的ASCII码来说。原理是,字符是相似的所以是容易混淆的,例如大写的O、小写的o还有0,小写的l和数字1,方括号和大写的I,都有相似的输出编码。这是非常有用的如果系统连接一个可以纠正混淆的语言后处理程序。因为可能被混淆的类的编码是相似的。匹配的BFS的输出对于模糊不清的特征是相似的,并且后外处理程序可以选择出适当的翻译。图3给出了所有的ASCII码的编码输出。使用分布式编码的另一原因是,不是常见的1-N编码(也称为地方编码或祖母细胞编码),对于输出不是分布式编码,当类的数量比几十个还大时,输出结果是糟糕的。因为输出单元是非分布式编码所以一定花费了大部分时间。对于函数单元这是非常难实现的,另一个原因分类器不仅要识别字符还要识别非字符。分布式编码的RBF是更合适的,不像函数,他们是很活跃的当输入空间是非常有限的,外部的任何不经典的模式将更容易失败。BFS的参数向量扮演者目标向量的角色在F6层。值得指出的是,这些向量是由 1和-1组成,刚好在F6的函数范围内,阻止这些函数饱和。实际上,-1和 1是函数的极值曲率。这使得F6单元运行在他们的最大非线性范围内,必须避免函数饱和,它将减慢收敛使得损耗函数病态化。

损耗函数

可以用在以上网络的最简单的损耗函数是最大似然估计,等价于最小均方误差(MSE)。训练样本的标准如下

是第 层RBF单元的输出,符合输出模式的正确类。费用函数和大多数情况一样缺少三个重要的特征。第一,如果我们允许RBF的参数改变, 有一个不重要的但是完全不能接受的结果。这个结果中所有的RBF参数向量是相等的,且F6层是不变的并且等于参数向量。这种情况下网络将忽略输出,所有的RBF输出等于0 。这个崩溃的现象不会出现如果RBF的权重不允许改变。第二个问题是,类之间没有竞争。竞争可以产生通过使用一种更有识别能力的训练标准,被称为最大后验标准(MAP)和最大共同信息标准类似,有时被用于训

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[138298],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。