英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

外文题目: From Word Embeddings To Document Distances

2016年 4 月 15 日

从词嵌入到文档距离

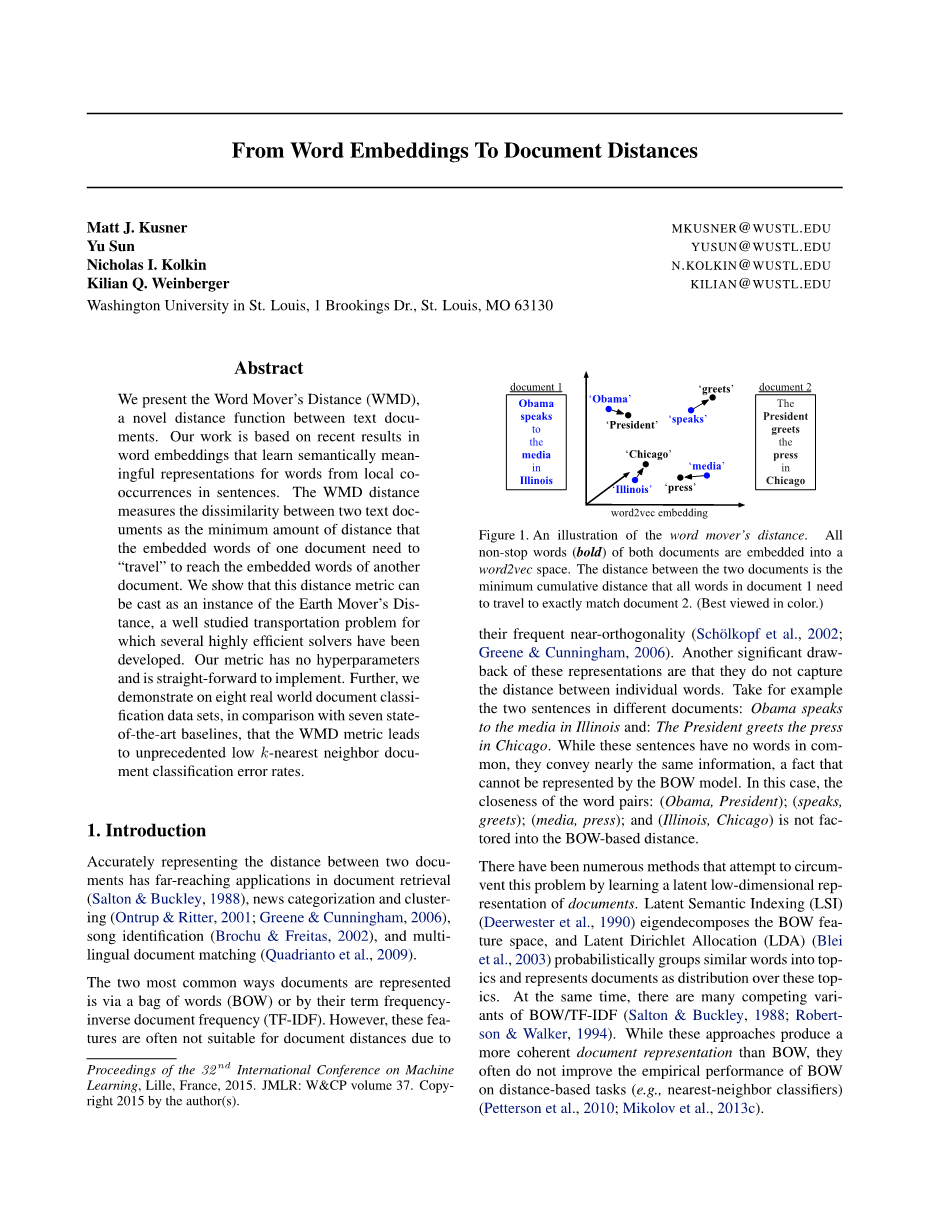

摘要:我们提出了词动距离(WMD)的概念——一种新的计算文本文档之间的距离的函数。我们的工作是以最近研究词嵌入的结果为基础的,而词嵌入是语义地学习那些来自句子中局部共现的词语的有意义的表示。WMD距离测量两个文本文档之间的不同,作为一个文档中的词语移动到另一个文档中的词语所需的距离之和的最小值。我们展示这种距离度量标准能够作为WMD的一个实例来计算出来,为了解决一个充分研究了的运输系统问题已经开发出了几个高效率的解决方案。我们的度量标准没有超参数,是直接实现的。因此,我们用8个真实存在的文档分类数据集进行论证,并与7个最新的基线进行比较,结果显示WMD度量标准产生了目前最低的K近邻文档分类错误率。

- 引言

准确地表现两个文档之间的距离已经广泛应用到文档检索、新闻分类和归并、歌曲识别和多语言文档匹配等多个方面。

有两种最常用的表示文档的方法,通过词袋(BOW)或他们的词频和逆向文档频率(TF-IDF)。然而,这些特征频繁的近正交性使得他们常常不适用于文档距离。不能获得单一的词语的距离是词语表示的另一个重要缺点。以取自不同文档中的两个句子为例:Obama speaks to the media in Illinois 和 The President greets the press in Chicago 。当这些句子没有公共的词语,但是表达的意思基本相同时,这个事实就不能通过BOW模型表示出来。在这种 情况下,联系紧密的词语对:(Obama, President); (speaks, greets); (media, press); 和(Illinois, Chicago)就不能作为因素计入基于BOW模型的距离中。

图1.这是关于WMD的一张图解。将两份文档的所有非停用词嵌入到一个词向量空间。文档1的所有词准确匹配到文档2所经过的最小距离的累计就是两份文档之间的距离。(最好通过颜色来观察)

有很多方法通过学习文档的潜在低维表示去尝试着解决这个问题。潜在语义索引(LSI)特征分解BOW特征空间,隐含狄利克雷分布(LDA)将相似的词归并到一个主题中,然后用这些主题代表文档的分布。同时,还有许多BOW或TF-IDF的变体是相互矛盾的。虽然有时候这些方法产生了比BOW更清晰明了的文档表示,但是大多数情况下他们没有改善BOW在基于距离的工作上的经验主义的表现。

在这篇论文中,我们介绍一种新的度量文本文档距离的标准。Mikolov提出的著名的word2vec模型产生空前的质量和规模的词嵌入,对于非常庞大的数据集显得很自然,我们的方法就是利用Mikolov等人最近的研究结果。(例如:我们使用一个用大概1000亿个词进行训练的免费且可用的模型。)作者证明了在词向量在进行向量运算时语义关系得到了保持,例如:。这表明词向量之间的距离有一定的语义意义。我们的度量标准叫做词动距离,利用词向量嵌入的性质。我们用词的加权点云来表示文本文档。

这种以WMD为基础的最优化问题可以归纳为已经充分研究过的地动距离交通系统问题的一个特例,而且我们可以利用现有的稳固而且专业的解决方案的文献。我们也可以比较几个较低的界限,说明这些能够作为近似值使用,或者删除掉那些已被验证不在一次查询的k个近邻之中的文档。

WMD有几个有趣的特点:1、不受超参数约束,可以直接理解和使用的;2、说明性很强,因为两个文档之间的距离可以拆开,用几个可用词语的稀疏距离说明;3、能很自然地将编码后的知识并入到词向量空间中,形成高的检索精度——胜过7个最新的用6个或8个真实的分类任务实践的文档距离计算方法。

- 相关工作

构造文档之间的距离与学习新的文档表示方法紧密联系在一起。Salton 和 Buckley是为了系统地学习基于频率的权重、标准化术语和基于语料的统计资料的不同结合而产生首次成果之一。Okapi BM25函数是另外一种变形体,它为每一个(词,文档)对进行评分,是为排序方面的应用设计的。Aslam 和 Frost源自于计算两篇文档之间的信息理论相似度,它是基于词在一篇文档语料中出现的频率。Croft 和Lafferty 和LDA类似,利用一种语言模型来描述一篇文档生成某个词语的概率。Wan是第一个通过文本分割将每篇文档分解成一系列的小标题单元,然后以EMD的方式测量将一个小标题单元转换成另一个所需的努力,我们的方法和他的大部分相似。

学习文档表示的新方法有SDA 和进一步研究了的mSDA,mSDA通过除去堆积的神经网络中的噪音的方法来学习词之间的联系。最近,Perina提出的成分的计数网格 融合LDA和网格计数模型,让“主题”成为词分布的混合体。同样地,Le 和 Mikolov受词word2vec模型的启发,利用一种简化的神经语言模型得到一种对文档的密度表示。EMD的使用开辟了计算机视觉文献。几个出版物研究EMD应用于图片检索的可能性。正如词嵌入使得质量大大改善一样,文档检索也进入了类似的阶段,在这里每个词都与一个高度信息化的特征向量联系在一起。据我们所知,我们的工作是第一个将高品质的词嵌入技术和EMD检索算法联系起来的。

Cuturi 介绍了对EMD对象的熵惩罚,她用非常有效的迭代的矩阵更新来处理结果的近似值。进一步说,向量化使通过GPGPU进行并行计算成为可能。然而,他们的方法假设每篇文档的维数不是很高 ,然而在我们的设定里维数是极大的(所有可能的词)。这使他们方法的主要作用(在通用图形处理器GPGPU上并行运算)没有发挥作用的地方,我们开发了一种新的EMD近似方法,对于我们的问题领域好像非常有效。

- Word2Vec词嵌入

最近Mikolov 等人提出一种新奇的词嵌入程序。他们还特别提出一种神经网络结构(skip-gram模型),该模型包含有一个输入层、投影层和输出层,用以预测周边的词。训练词向量来记录一个语料库中临近单词的最大的可能性,即给出一列词,

nb(t)是词的邻近单词的集合,是两个关联词向量和的层次softmax。由于skip-gram模型结构惊人的简单以及层次softmax的利用,该模型能够在单片机上训练得到,而且用常规的桌面电脑就可以每小时训练10亿个词。能够在很大的数据集上训练的能力使得该模型能够学习复杂的词表示,例如和。学习词嵌入是完全无监督的,可以对感兴趣的文本语料库计算或提前预计算。虽然我们用word2vec作为整个我们的首选嵌入,其他的词嵌入也是类似的。

- 词动距离(WMD)

假定我们有一个n个词组成的大小限定的词典以及他们的word2vec词向量矩阵 。第i列,xi isin; Rd 表示d维空间的第i个词的词向量。我们假定文本文档用标准的词袋向量表示,d isin; Rn。确切地说,如果词i在一个文档中出现次,我们指定。一个nBOW向量自然很稀疏,因为大多数次不会出现在任何给定的文档中。(我们去掉停用词,他们通常对于分类不起作用。)

nBow表示。我们可以将向量d看成n-1维单一词分布空间的一个点。两篇拥有不同词的文档就会分布在这个空间的不同区域。然而,这些文档在语义上可能还是相近的。回想之前在一个文档中两个句子意思相近但是词不同的例子:“Obama speaks to the media in Illinois”和“The President greets the press in Chicago”。在去掉停用词后,这两个对应的nBOW向量d和没有公共的非零维度和因此有接近单纯形的最大距离,虽然他们的真实距离很小。

词移动代价。我们的目标是结合单一的词对(President和Obama)的相似度到文档距离度量标准中。在word2vec嵌入空间中的欧式距离自然提供了一项措施。更准确地说,词i和词j之间的距离变成了。避免在词距离和文档距离之间造成误解,我么引用作为从一个词移动到另一个词的代价。

文档的距离。'旅行费用'两字是天然的构建基块,创建两个文档之间的距离。让d和代表n-1单一体中两个文档的nBOW表示。让d和代表n-1单一体中两个文档的nBOW表示。首先,我们允许d中的每个单词i转化成中 全部或部分的任何单词。把T isin; Rntimes;n 当成一个稀疏矩阵,当Tij ge; 0时,表示d中的词i移动到的词j的代价。为了把d 完全转换成,我们要确保从词i的整个输出流要等于,即。 进一步说,词j的输入流必须等于。最终,我们能将d中所有词移动到所需的累积代价的最小值定义两篇文档的距离,即。

图2.这是构成WMD在一个句子和两个句子、(有相同的BOW距离)度量标准。箭头表示两个词之间的流,并标有他们距离贡献。(底部:)两个句子 D3 和 D0 与不同数量的单词之间流动。这种不匹配会导致大规模毁灭性武器将文字移动到多个类似的词。

运输问题。形式上来说,下面的线性程序为移动 d 到的最小累计值给出了一些限制条件,

subject to: (1)

上述的优化是地球移动距离度量 (EMD) 的一个特例,为了解决充分研究了得运输问题而专门制定了解决方案。要突出我们将由此产生的度量称为词移动距离 (WMD)的关联。正如成本 c(i,j) 是一个度量,易得WMD也是一种度量。

可视化。图 2 显示了WMD度量标准在两个句子D1 和 D2的使用,我们要与查询句D0进行比较。首先,去掉停用词,D0中留下President, greets, press, Chicago ,每个词的di = 0.25。从 D1和D2中的每个词i到D0中的词j的 箭头标上了它们对距离Tijc(i,j)的贡献。将Illinois 转换成Chicago的代价比将Japan转换成Chicago的代价小得多。这是因为word2vec将和放得比和近。因此,从 D0到 D1 的距离 (1.07) 明显小于D0到 D2的距离 (163)。然而,重要的是 从D0到D1和D2 这两句有同样的词袋/TF-IDF 距离,同样地都没有和D0有相同的词。另一个例子 D3显示了当两者的单词的数量不相等时的流动。D3 的词权重 dj = 0.33 和多余流量发送到其它相似的词语。这样将会增大距离,虽然效果可能会被人工放大,因为相较于短文本,较长的文档可能会包含几个意思相似的词语。

4.1远距离计算

解决WMD优化问题的平均时间复杂度为 O(p3 logp),其中p表示文档中独一无二的单词的个数。对于具有许多独一无二的单词的数据集 (即高维) 和大量的文档,解决WMD最优运输问题可能会很难。然而,我们可以引入几个廉价的下限更低的WMD运输问题,使我们能够删去绝大多数没有

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[152302],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。