英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

摘要:本文提出了一种方法来针对行为识别进行视频范围内的时域信息捕获。 我们假设存在一个函数可以暂时较为完美地针对视频内演化而产生的被捕获帧进行排序。 我们通过排序机器来利用每一段视频对排序函数进行训练并使用这些参数作为一个视频的新的陈述。新提出的方法很容易解释和实现,易于快速计算和有效地识别各种各样的行动。

对于通用动作识别(Hollywood2和HMDB51),细粒度动作(MPII-烹饪活动)和手势(Chalearn),我们对这些数据集进行了大量的评估。 结果表明,提出的方法带来了正确率提高7-10%的效果,同时兼容与进一步改善外观相辅相成和基于局部动作的方法。

1.介绍

在过去十年中,大部分动作识别领域的过程与这些相关:i)局部时空描述法的发展(从感兴趣的点中提取,越过密集样本和密集轨迹,从基于梯度的描述基元到基于动作和基于运动补偿的基元)或ii) 采用已经有了良好的物体识别记录的强大的编码方案(例如Fisher矢量图[38])。

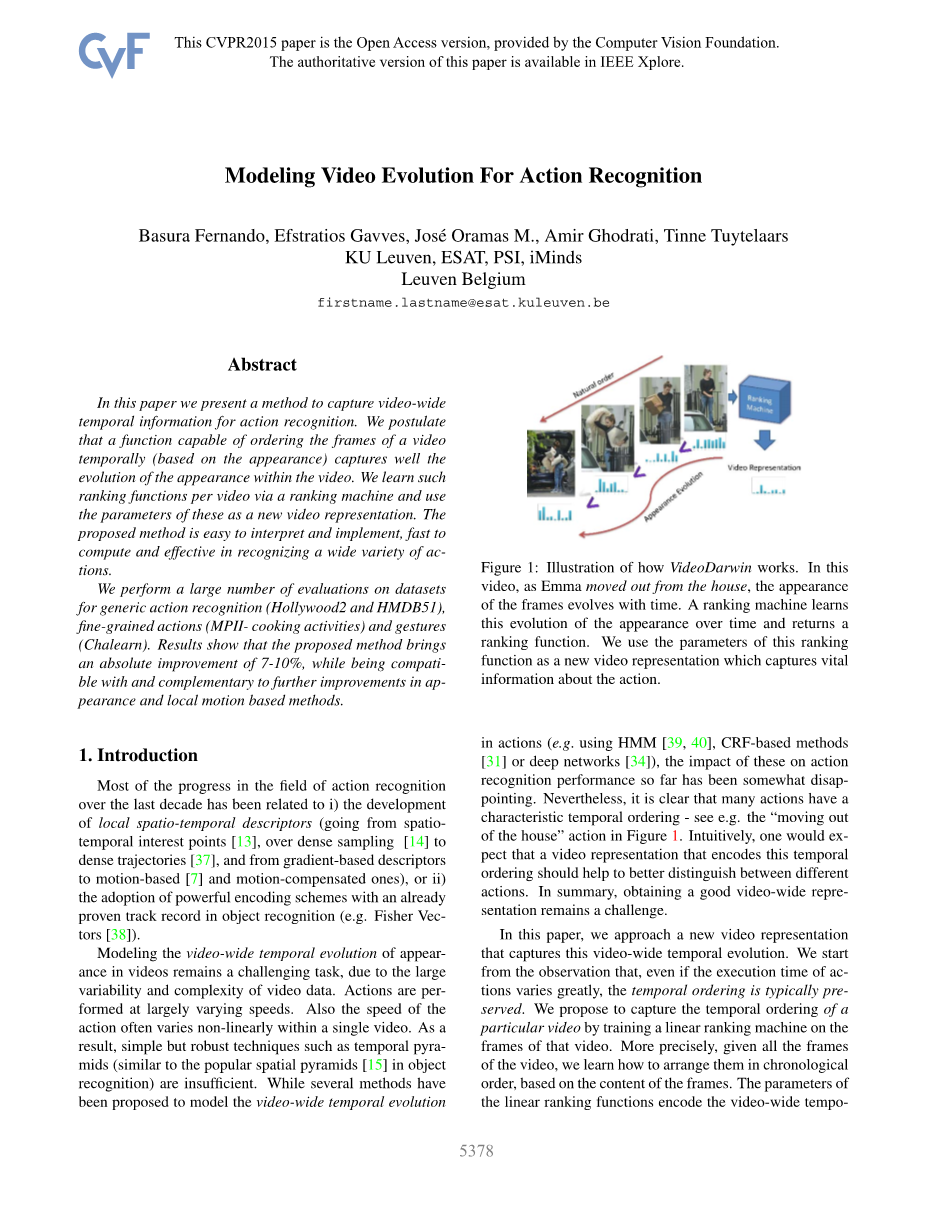

由于规模庞大的视频数据的可变性和复杂性,对视频宽度时域演化的建模仍然是一项具有挑战性的任务。 动作以大量的变化速度被显现出来。在一个视频内动作的速度经常做非线性变化。结果,通常简单但有效的技术,如时间金字塔(类似于受欢迎的空间金字塔[15]识别)存在其不足。 虽然有几种方法被提出来模拟视频时域演进图(如HMM,CRF,深度网络等),这些对算法对行为识别的贡献到目前为止并非完全尽如人意。然而,很明显,许多行动都有特征时序。见“从房子中出去”这个行动,如图1。直观地,人们会期待一个存在一种对时域排序的视频描述能够更加有效的区别不同的动作。总而言之,获得一个良好的视频表述仍然是一个挑战。

图1

在本文中,我们提出一个新的视频描述法,它捕捉了这个视频范围内的时间演变。我们从观察中发现即使动作的执行时间差异很大,时间顺序通常会被保留下来。我们打算捕捉一个特定视频的时间序列,为实现这个目标我们需要训练一个基于该视频帧的线性的排序机器。更确切地说,给出了视频的所有帧,我们学习如何按时间顺序对它们进行排序,根据帧的内容。线性排序函数的参数以原则性的方式对视频的视频时间演变进行编码。为了训练这样的排序机器,我们使用监督学习对帧进行排序。接受了培训相同动作的不同视频的排序机器可以被认为有类似的排序功能。因此,我们打算使用排序机器的参数序列作为新的视频表述并应用于动作识别。针对这种新的表示方法训练好的分类器被认为是对区分动作十分有益的。由于排序机器对帧内容进行操作(在我们的实验中本地时空描述符),他们实际上随着时间捕捉外观和他们的演变。我们称之为VideoDarwin方法。

我们的主要贡献是使用排序函数参数作为基于捕获视频的视频时间演进的新的视频表述。 我们的新视频表述是基于一种范例学习方法,它易于实施且高效。 最后但并非不重要的是,通过新的表述我们获得了行为和姿势识别的最先进的结果。

本文的其余部分组织如下:第2节我们定位我们的工作为w.r.t. 现有工作。 第3节描述我们的方法。 其次是在第4节评估我们的方法。我们在第5节结束本文。

2. 相关工作

捕获视频的时间信息以进行动作识别是研究领域研究的热点。对短帧序列本地动机形式的建模的有意义的进展被一次次的见证 [13,37,38]。 Jain等人 [8]提出首先将行动定位在视频中利用它们来进行识别。为避免使用hand-engineered特征,深入学习方法论[16,34]也被继续研发。 动态深度网络中可以通过扩展来捕获网络架构在时间上的连通性[11]或使用堆叠的光流代替框架作为输入网络[29]。 虽然上述方法在较短时域窗口内成功捕获本地变化,它们并不是为了更高层次的建模而设计的,而且视频内表现/动机的动机与确切的动作相关。

在建模高级运动模式时,机器学习方法,如CRF,HMM和动作语义,已被研究用于动作识别[24,27,31,33,39]。在[39]中,基于部分的方法与大规模模板特征结合起来并用来获得基于最大边缘隐藏条件随机域的辨别模型。在[31]中,宋等人依靠一系列复杂的启发方法并为指定的CRF模型定义特征函数。[33] Tang等针对视频中的时间结构提出最大边缘的建模方法。他们使用HMM模型来捕捉动作形式的变化和动作的变化。

时间序列模型也被应用于复杂活动识别的环境[6,26,32]。他们主要着重从预定义,语义有意义的基层动作检测器推断复合活动。在[32]中,使用HMM模型提出了事件的表示编码原子动作过渡的统计信息概率。类似于上述工作,我们利用视频的时间结构,但在对比方面,我们依靠排序功能来捕捉演变的外观或局部动作。使用学习排序范式,我们得到一种针对每个视频的功能表示法。

由于视频中运动模式的变化很大,通常潜在的顺序模型效率不高。应对有这个问题,表现形式的时间金字塔[4,14]或视觉特征的直方图序列[3]被引出。与他们不同,我们明确视频范围内的视频级动态使用原则学习范式。此外,与[3]相反,我们的表述方法不需要在训练时对动作元作手动注释。最近,一项与编辑对象有关的研究被用于编码视频中行为并有利于视频表述中的行为分类,见[9]。

我们的工作在概念上与机遇几何模型的函数表述法有一些相似。因为我们使用线性函数的参数作为新的表示方法,我们的工作也与样本SVM概念有一些相似之处[18],但我们的目标是学习代表视频中一组帧的相对排序。在同时我们不需要依赖负面数据来学习表示方法,就像示例SVM的情况一样。

3.针对动作识别的VideoDarwin

在这项工作中,我们的目标是开发视频表示它捕捉了视频广泛的时态进化(VTE)视频。为了实现这一点,我们考虑一个视频矢量值函数,并学习排序基于帧的外观向量或局部运动矢量。 在3.1节,介绍VideoDarwin的核心思想。 然后在第3.2节中,我们选择一个鲁棒的视频向量值函数来捕捉视频内容的演进。 VideoDarwin的管道如图2所示。

3.2. Vector valued functions for VideoDarwin

在本节中,我们寻求向量值函数?(?)= vt的良好表示。 我们讨论从帧数据xt构造向量值函数?(?)的三种方法。

方法1:独立帧表示

最直截了当用于捕获视频外观演变的表示法是使用独立帧作为向量值函数的输出。该方法可能有两个缺点。 首先,原始信号可能相当嘈杂(参见图3(a)),这将导致排名机器学习不良噪声。 同时,该策略可能会在训练时间内产生高排名错误的排名功能。 其次,独立帧表示导致vt和...之间的弱连接。鉴于此之间的弱相关性vt和时间..(见图3(a)),排名函数可能不会随着时间的推移学习外观演变。结果,绘制预测得分.... = ui .. 视频中的每个帧的视频不一样平滑(见图3(d))。

方法2:移动平均线(MA)

受到时间序列分析文献的启发,我们考虑窗口大小?作为视频表示的移动平均值。换句话说,我们考虑局部平滑的信号。对于MA,我们观察到两个事实:首先,输出信号更平滑(见图3(b)),其次vt本地取决于帧[?,? ?]。与独立帧表示不同,移动平均模型伪造vt和a之间的连接。对于图3(b)中的窗口T = 50绘制这两个变量,我们观察到vt的维度和帧号(时间变量)之间的平滑关系。这反映在捕获的全球时间信息以及预测得分??中(见图3(e))。虽然移动平均表示能够更好地捕获视频的外观演变,但我们仍然看到信号的一般不稳定性。而且,移动平均代表引入不需要的伪像。首先,必须选择窗口大小?,这并不总是直接的,因为行动经常发生在不同的节奏。第二,由于对[?,? ?]帧的依赖,自然会忽略视频的最后一帧。这是有问题的,特别是对于视频持续时间较短情况下这种现象更为明显。

方法3:时间变化的平均向量。

为了处理独立帧表示和移动平均的限制,我们提出使用时变均值向量。 Letus表示时间的平均值asmt =1?times;Sigma;?tau;= 1xtau;。然后,vt仅捕获在时间?处的单位平均出现向量的方向,即(vt = mt||mt||)。因此排名功能:psi;学习时间?的归一化均值外观的演变。我们绘制图3(c)中vt和?之间的关系以及图3(f)中的预测分数。我们观察到,根据需要,输出光滑,几乎类似于单调增加的功能。与独立帧表示不同,时变平均向量在输入??和目标vectors之间引入更好的依赖关系。通过构建时变均值向量仅捕获视频相对于时间的向前流动的时间信息(如视频从过去到未来帧的进展)。然而,没有理由不应该考虑平均矢量也以相反的顺序,从未来的帧开始并且向后遍历到视频的过去帧。为此,我们产生完全相同的目标,如同

EQ。以相反的顺序播放视频。我们将转发视频数据转换为前向流捕获的外观演进,反向视频转换为反向流。视频分类与SVM。为了捕获VTE,我们通过应用eq来优化psi; ((1)分别为每个视频)一次。然后,矢量ui表示视频的外观信息的视频特定演进??,见图2最后一列。接下来,为了将视频分类到类中,我们对我们的VTE表示数据集使用标准监督分类方法??????= {ui,??},?= 1,。 。 。 ?其中?是我们的训练集中的视频数量,??是??ℎ视频的分类标签。我们使用非线性SVM分类器,如应用于特征向量uiisin;的卡方特征图[35]。

最后,我们总结了Video-Darwin的一些优势。不需要监督信息,因为视频订单约束可以直接从视频帧序列获得。它利用原则和有根据的最大利润率学习策略来捕捉视频的外观演变。学习排名框架不需要任何明确的负面数据。因此,VideoDarwin在表示学习阶段不需要任何负数据。由于我们的方法封装了视频中发生的变化,因此它捕获了有用的辨别信息以进行动作识别。它可以被认为是一个集合策略,我们称之为级别池。

4.实验

现在我们对VideoDarwin.Datasets进行详细的实验评估。由于所提出的方法不是特定于动作类型或类别的动作,因此我们在广泛的数据集中提供实验。我们遵循与数据集完全相同的实验设置,使用与现有技术方法报告相同的训练和测试分裂以及相同的特征。 HMDB51数据集[12]。这是一个通用的动作分类数据集组成。该数据集的视频和动作受到不同的摄像机运动,视点,视频质量和遮挡。如文献中所做的那样,我们使用一个vs分类策略,并报告作者在[12]中提供的三个标准分割的平均分类精度。好莱坞2数据集[14]这个数据集已经从69个不同的好莱坞电影收集,包括12个动作类。共有1,707个视频,共823个视频用于培训,884个视频用于测试。从不同的电影中选择训练和测试视频。该性能是通过平均精度(mAP)来衡量的,如[14]所示。 MPII显示活动数据集用于细粒度动作分类[25]。创建此数据集以评估细粒度动作分类。它由65个不同的动作组成,在录音后8小时内连续进行。由于厨房在整个录音中保持不变,所以分类主要集中在动作的内容上,并且不能从潜在的歧视背景信息中获益(例如驾驶汽车总是在车内进行)。我们使用与[25]和报告中相同的步骤计算每个类的平均精度最后的mAP。

ChaLearn手势识别数据集[2]。该数据集包含23个小时的Kinect数据,27个人执行20个意大利手势。数据包括RGB,深度,前景分割和Kinect骨架。数据分为训练,验证和测试集,总共955个视频每个持续1到2分钟,包含8到20个非连续手势。如文献中所述,我们在验证集上报告精确度,召回率和F1评分。 VideoDarwin和基线。在第4.1和4.2我们比较了VideoDarwin的不同变体。作为第一个基准,我们使用最先进的轨迹特征(即改进的轨迹和密集轨迹)和管线,如[38,37]所示。由于这个基于轨迹的基线主要考虑局部时间信息,所以我们把这个基线称为局部的。我们还与时间金字塔(TP)进行比较,首先将视频分割成两个相等大小的子视频,然后计算每个像空间金字塔的表示[15]。对于这些基线,在帧级,我们应用非线性特征图(即功率归一化)对于Fisher矢量和基于方法的基于方法的卡方核映射)。我们还比较了不同版本的VideoDarwin,我们通过FDVD表示Forward VideoDarwin,通过RFDVD反转和转发VideoDarwin,NL-FDVD的非线性前向VideoDarwin和NL-RFDVD的非线性反向和转发VideoDarwin。

对于HMDB51和Hollywood2数据集,我们使用最先进的改进轨迹特征[38]与Fisher编码[22]。如文献中所述,我们从视频中提取HOG,HOF,MBH和轨迹(TRJ)特征。在应用PCA之后,我们创建大小为256的GMM,每个描述符的维数降低为0.5。如[38]所述,我们还对所有描述符应用平方根技巧,除了TRJ。为了计算非线性VideoDarwin,我们对从每个视频帧提取的每个Fisher向量应用功率归一化,然后进行L2归一化。对于线性VideoDarwin,我们只使用Fisher向量任何功率归一化。对于MPII烹饪数据集,我们使用提供的功能 [25],这是从密集轨迹特征[37](HOG,HOF,MBH和TRJ)提取的尺寸为4000的袋字直方图。当我们使用这个数据集的包,为了计算非线性VideoDarwin,我们在构建向量值函数之后,在单个的单词字符直方图中应用chi;2-内核映射,如3.2节所述。对于ChaLearn手势识别数据集,我们从使用[28]的方法估计的身体关节开始。对于每个帧,我们计算每个身体关节w.r.t.的相对位置。躯干关节。然后,我们在[0,1]范围内缩放这些相对位置。我们使用100的字典用来量化这些骨架特征的单词。类似于MPII烹饪数据集,为了计算非线性VideoDarwin和所有基线,我们使用卡方核心映射。我们训练非线性SVM分类器与特征核心映射进行最终分类。每当我们使用bag-ofwords表示,我们在最终的视频表示中计算chi;2-内核映射,然后L2对它们进行规范化。我们对两个基线

全文共5903字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[144135],资料为PDF文档或Word文档,PDF文档可免费转换为Word