英语原文共 21 页,剩余内容已隐藏,支付完成后下载完整资料

在人工网络中用网格样表征进行基于向量的导航

Andrea Banino1,2,3,5*, Caswell Barry2,5*, Benigno Uria1, Charles Blundell1, Timothy Lillicrap1, Piotr Mirowski1, Alexander Pritzel1, Martin J. Chadwick1, Thomas Degris1, Joseph Modayil1, Greg Wayne1, Hubert Soyer1, Fabio Viola1, Brian Zhang1, Ross Goroshin1, Neil Rabinowitz1, Razvan Pascanu1, Charlie Beattie1, Stig Petersen1, Amir Sadik1, Stephen Gaffney1, Helen King1, Koray Kavukcuoglu1, Demis Hassabis1,4, Raia Hadsell1 amp; Dharshan Kumaran1,3*

深度神经网络在从对象识别到复杂游戏(例如Go1,2)等领域都取得了令人瞩目的成功。然而,对于人工智能而言,导航仍然是一个严峻的挑战,通过强化学习训练的深层神经网络3-5无法与由内嗅皮层中的网格细胞所支撑的哺乳动物空间行为的能力相提并论。网格细胞被认为提供了多尺度的周期性表示,其用作对空间进行编码的度量7,8,对于整合自我运动(路径整合)6,7,9和规划到达目标的轨迹(基于矢量的导航)至关重要)7,10,11。本文着手利用网格单元的计算功能来开发具有类似于哺乳动物的导航能力的深度强化学习智能体。我们首先训练了一个循环网络来执行路径整合,得到类似于网格细胞以及其他内嗅细胞类型的表征12。然后,我们证明了这种表示方法为智能体在具有挑战性,陌生且多变的环境中定位目标提供了有效的基础-深度强化学习的方式优化了导航的主要目标。具有网格结构的智能体的表现优于人类专家和其他与之比较的智能体,而基于矢量的导航所需的度量值则源自网络内的网格状单元。此外,网格结构使智能体更直接的接近于哺乳动物的行为。我们的发现表明,类似的网格结构示为智能体提供了欧几里得空间度量和相关的矢量运算,为熟练的导航提供了基础。因此,我们的研究结果支持了将网格细胞视为基于矢量的导航的关键7,10,11的神经科学理论,这表明网格可以与基于路径的策略相结合,以在具有挑战性的环境中进行导航。

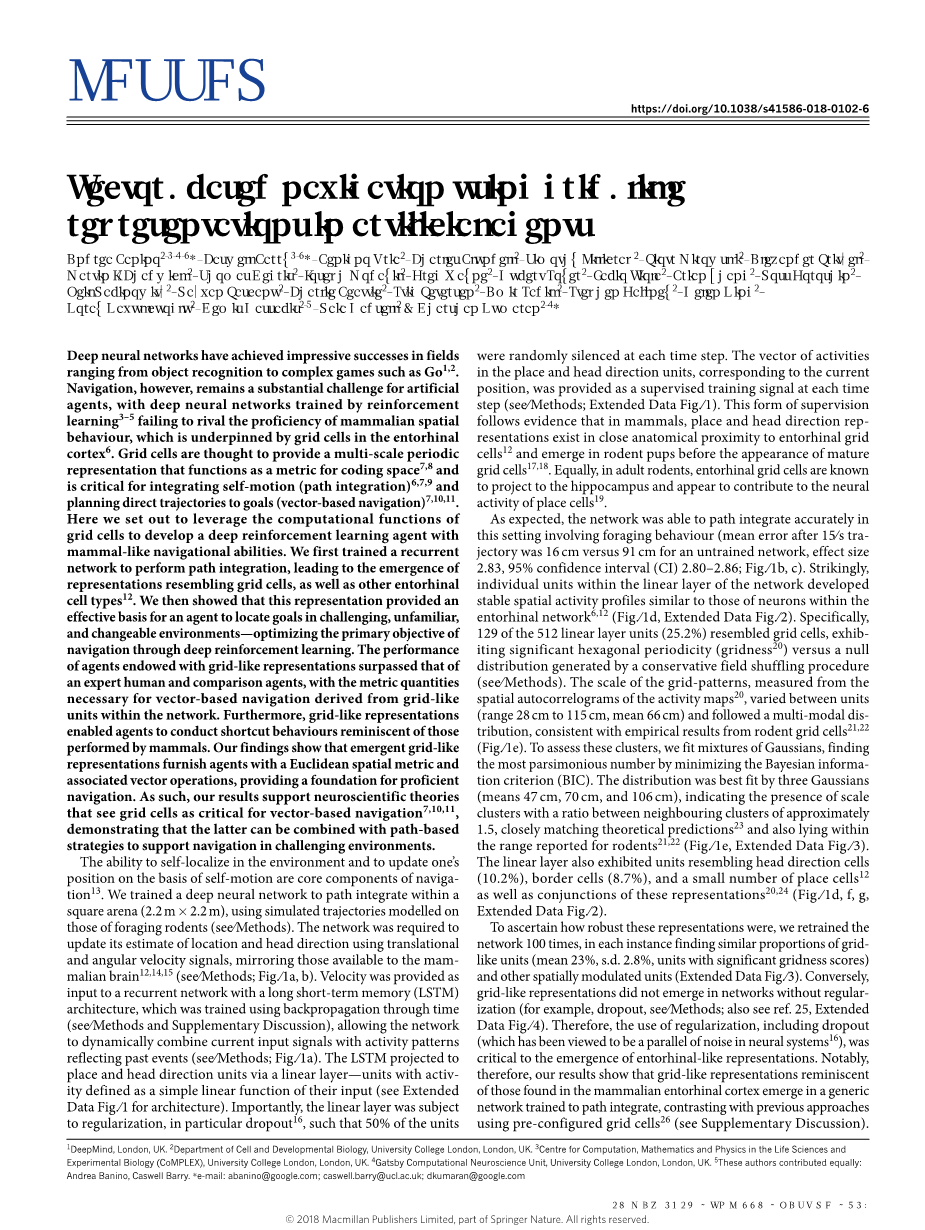

导航的核心组成部分是在环境中自我定位并根据自我运动更新位置的能力13。我们使用在觅食啮齿动物身上建模的模拟轨迹训练了一个深度神经网络,并在正方形区域(2.2 mtimes;2.2 m)内进行路径整合。该网络需要使用平移和角速度信号更新其位置和朝向,以反映哺乳动物大脑12,14,15可用的信号(参见方法;图1a,b)。速度作为长期短期记忆(LSTM)架构的循环网络的输入,该网络使用反向传播进行了训练(请参见方法和补充讨论),从而使网络可以动态地将当前输入信号与反映过去的活动模式组合在一起事件(请参见方法;图1a)。 LSTM预计将通过使用线性激活函数的线性层位置和朝向单元(有关体系结构,请参见图1的扩展数据)。线性层要经过正则化,尤其是使用随机失活16,以便在每个时间步长随机将50%的单元失活。对应于当前位置的位置和朝向矢量在每个时间步均作为监督训练信号提供(请参见方法;扩展数据图1)。这种形式的监督遵循的证据表明,在哺乳动物中,位置和朝向与解剖学上的内嗅网格细胞紧密相连12,并在成熟网格细胞出现之前出现在啮齿动物幼崽中17,18。同样,在成年啮齿动物中,内脏网格细胞会投射到海马体上,并可能对位置细胞的神经活动有贡献19。

图一:内啡肽样表达出现在经过训练以进行路径整合的网络中。 a,网络结构示意图(请参见图1的扩展数据)。 b,示例轨迹(15 s);从位置细胞解码的定位位置(深蓝色)类似于实际路径(浅蓝色)。 c,精度。训练前(蓝色)和训练后(绿色)的解码位置。 d,线性图层单元显示出空间调整后的响应,类似于网格,边界,和朝向细胞。顶部的费率图显示了地理位置上的活动;标明网格度的速率图的中间空间自相关图;底部极坐标图显示了活动与头部方向的关系。 e,空间尺度。网格状单元(n = 129)是聚类的。分布比偶然性更离散(影响大小为2.98; 95%CI为0.97-4.91),并且最好是由三个高斯混合而成(中心0.47、0.70和1.06 m,比率为1.49和1.51)。 f,定向性最强的单位(n = 52)。线表示合成向量的长度和方向(请参阅《方法》),展现出六倍的聚集网格,使人联想起联合网格单元格。 g,网格度分布和方向调整。虚线表示从零分布开始的95%置信区间(基于500个数据排列); 14个(11%)网格具有方向调制(请参阅方法)。在循环环境中观察到类似结果(扩展数据图.3)。

如预期的那样,网络能够在这种涉及觅食行为的设置中准确地进行路径整合(15秒后轨迹的平均误差为16 cm,而未经训练的网络为91 cm,效果大小为2.83,95%置信区间(CI)2.80– 2.86;图1b,c)。令人惊讶的是,网络线性层中的单个单元发展出稳定的空间活动轮廓,类似于内嗅网6,12中的神经元(图1d,扩展数据图2)。具体而言,在512个线性层单元中有129个(25.2%)与网格单元相似,表现出显着的六边形周期性(gridness20)与零分布的保守性(请参见方法)。从活动图的空间自相关图测量的网格模式的规模在各单元之间各有不同(范围从28 cm到115 cm,平均66 cm),并遵循多模式分布,这与啮齿动物网络的经验结果一致单元格21,22(图1e)。我们使用高斯混合分布来进行拟合,通过最小化贝叶斯信息准则(BIC)来找到最简约的数字。该分布最适合三个高斯分布(分别为47 cm,70 cm和106 cm),表明存在鳞状星团,相邻星团之间的比率约为1.5,与理论预测值非常接近23,并且也处于啮齿类动物报道的范围内21,22(图1e,扩展数据图3)。线性层还表现出类似于头部方向单元(10.2%),边界单元(8.7%)和少量位置单元12的单元,以及这些表示的结合20,24(图1d,f,g,扩展数据图2)。

为了确定这些表示的鲁棒性,我们对网络进行了100次重新训练,在每种情况下都发现了类似比例的网络单元(平均23%,标准差2.8%,具有显着网格度得分的单元)和其他空间模式单元(扩展数据图) 3)。 相反,没有正则化的网络就不会出现类似网格的表示形式(例如,随机失活,请参见方法;另请参见参考资料25,扩展数据,图4)。 因此,使用正则化,包括随机失活,对于出现内嗅样表示至关重要。我们的结果表明,类似于哺乳动物内脏皮质中发现的网格状表示形式出现在经过训练以进行路径整合的通用网络中,这与以前使用预先配置的网格单元的方法形成了鲜明的对比(见补充讨论)。此外,我们的结果与以下观点相一致:网格单元显示出的自运动提示6-9更新的位置代码是有效且可靠的。

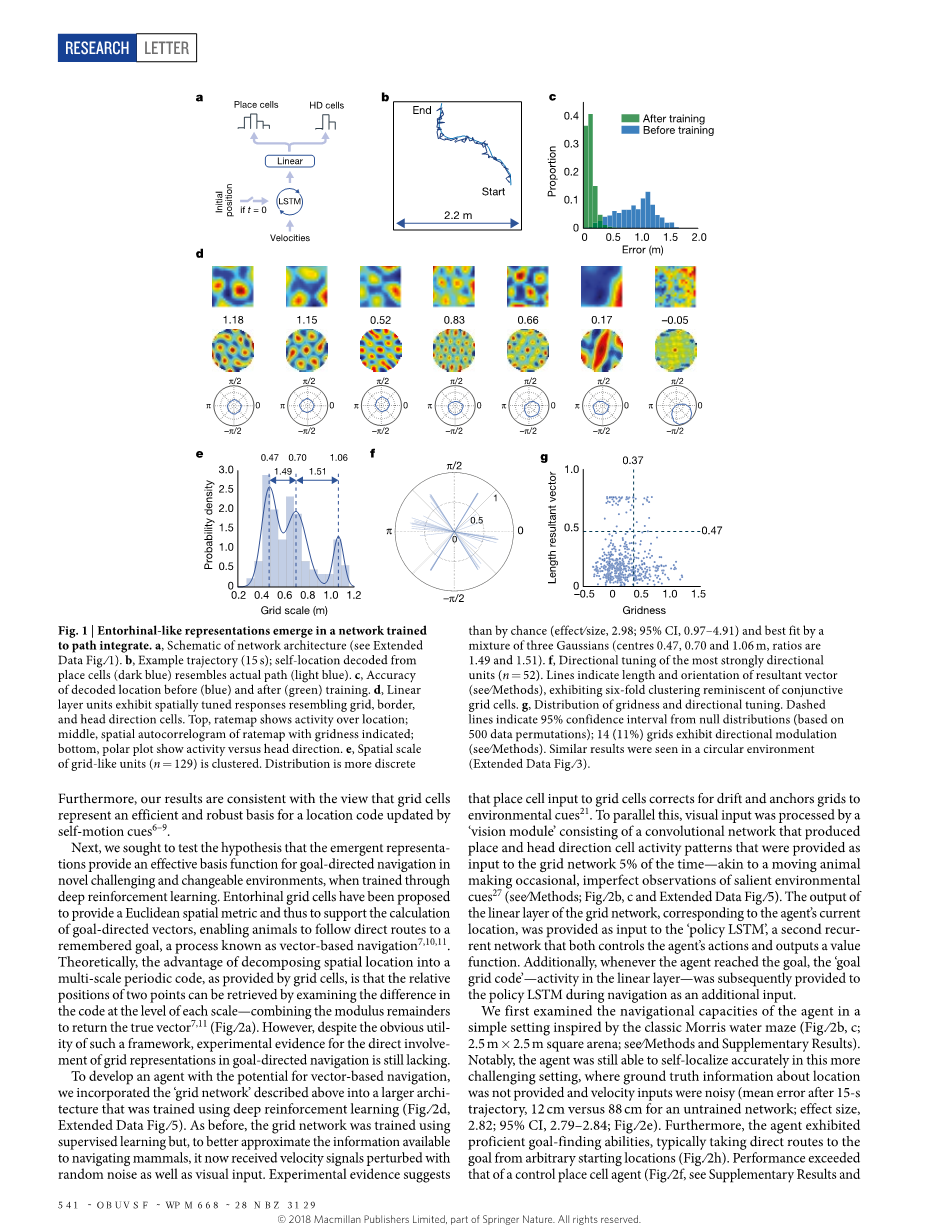

接下来,我们试图检验以下假设:通过深度强化学习进行训练时,新的表示法可以为复杂多变的环境中的目标定向导航提供有效支持。网格细胞可以提供欧几里得空间度量,从而支持目标导向矢量的计算,使动物能够直接到达被记住的目标,这一过程称为基于矢量的导航7,10,11。 从理论上讲,将空间位置分解为网格单元提供的多尺度周期代码的优势在于,可以通过检查每个尺度级别的代码差异(结合模数)来检索两点的相对位置——余数返回真实向量7,11(图2a)。 但是,尽管这种框架具有明显的实用性,但仍缺乏网格表示是直接参与目标导向导航的实验证据。

图二,单目标导航到隐藏目标。 a,基于矢量的导航示意图。 b,典型环境的俯视图(图标表示代理和朝向)。 c,b的智能体视图。 d,深度强化学习架构示意图(扩展数据图5)。 PCP,位置单元格预测; HDP,朝向细胞预测。 e,从位置单元解码的定位的准确性。 f,网格单元智能体和位置单元智能体的性能(y轴表示在一次情节中获得的奖励,每个目标到达10点,灰色带显示基于5,000个自举样本的68%置信区间)。 g,如图1所示,线性层发展出类似于内嗅皮层的空间表示。从左到右,两个网格单元,一个边界单元和一个朝向单元。h,在一个回合中,智能体探索找到目标并随后直接导航至目标。 “ S”表示起始位置。i,成功导航后,为策略LSTM提供了“伪造”的目标网格代码,将智能体引导到没有目标的位置。 j,k,根据网格单元和位置单元智能体的策略LSTM解码目标指示的度量代码(即,欧氏距离和方向)。相关系数的自举分布(1,000个样本)均以覆盖在Tukey箱形图上的小提琴图显示。

为了开发能够基于矢量导航的智能体,我们将上述的``网格网络合并到一个更大的体系结构中,该体系结构使用深度强化学习进行了训练(图2d,扩展数据图5)。和以前一样,网格网络是使用监督学习进行训练的,但是,为了更好地估计可用于导航哺乳动物的信息,它现在接收到了受到随机噪声和视觉输入干扰的速度信号。实验证据表明,将位置单元输入到网格单元可以纠正漂移并将网格固定为环境提示21。与此平行的是,视觉输入由“视觉模块”处理,该视觉模块由卷积网络组成,该卷积网络产生位置和朝向的细胞活动模式,产生了位置和朝向的细胞活动模式被提供给网格网络的时间为5%(与移动的动物类似,偶尔会出现不完善的显着环境提示27)(请参见方法;图2b,c和扩展数据图5)。网格网络线性层的输出(与智能体程序的当前位置相对应)作为“策略LSTM”的输入提供,“策略LSTM”是第二个循环网络,它在控制智能体的行为的同时输出奖励值。此外,只要智能体达到目标,“目标网格代码”(线性层中的活动)便会在导航期间作为附加输入提供给策略LSTM。

我们在经典莫里斯水迷宫的启发下用一个简单的环境测试了智能体的航行能力(图2b,c; 2.5mtimes;2.5m的方形竞技场;请参见方法和补充结果)。值得注意的是,在没有提供有关位置的地面真实信息,速度输入也加入干扰的复杂情况下(15 s轨迹后的平均误差:12 cm,未经训练的网络为88 cm)智能体仍然能够准确地自我定位 ;效果大小为2.82; 95%CI为2.79–2.84;图2e)。此外,智能体表现为能熟练的发现目标,通常会从任意起始位置直接进入目标(图2h)。选择的性能超出了对照位置细胞智能体的性能(图2f,请参见补充结果和方法),这是因为虽然位置细胞提供了自我定位的可靠表示,但它没有为远程矢量计算提供基础11。我们检查了线性层中的单元,再次发现了与内嗅皮层中相似的异质种群,包括网格状单位(21.4%)以及其他空间表示形式(图2g,扩展数据图6)-与哺乳动物网格细胞对自我运动信息15,28和空间线索6,21的依赖性。

接下来,我们回到中心论断,即网格单元赋予智能体执行基于矢量的导航的能力,使下游区域能够通过将当前活动与记住的目标的活动进行比较来计算目标导向的矢量7,10,11。 在智能体中,我们希望这些计算将由策略LSTM执行,该策略将接收线性层上的当前活动模式(称为``当前网格代码;图2d和扩展数据图5)以及最后一个智能体达到目标的时间(称为“目标网格代码”),并使用它们来控制移动。 因此,我们进行了几种操作,得出了四行证据,以支持基于矢量的导航假设(请参阅补充结果)。

首先,为了证明目标网格代码提供了足够的信息以使智能体能够导航到任意位置,我们将其替换为从环境中某个位置随机采样的``伪目标网格代码(请参见方法)。智能体沿着一条直接路径到达新指定的位置,绕过不存在的目标(图2i)-类似于莫里斯水迷宫探空试验中的啮齿动物(已移除逃生平台)。其次,我们证明了从网格细胞智能体的策略LSTM中保留目标网格代码会对性能产生很大的有害影响(扩展数据图6c)。第三,我们证明了网格细胞智能体的策略LSTM包含基于矢量的导航的关键组件的表示(图2j,k),以及两者的欧几里得距离(r = 0.17; 95%CI,0.11-0.24) )和同心目标方向(差异r = 0.22; 95%CI,0.18-0.26)比在位置细胞智能体中更强。值得注意的是,最近在哺乳动物海马中已经报道了目标距离的神经表示29。最后,我们提供了与基于矢量的导航假设的预测相符的证据,即目标网格代码中最接近网格状单元的目标病变(即沉默)比非网格单位的病变对性能和表示基于矢量的度量(例如,欧几里得距离)的影响更大。

图三,在具有挑战性的环境中导航。 a,b,目标驱动的(a)和目标门(即具有随机门; b)的多房间环境的俯视图。显示目标(星号)和智能体(头图标)的位置。 c,d,a和b的Agent视图分别显示红色目标和关闭的黑色门。 e,f,分别为a和b的Agent训练性能曲线,以及人类专家的性能(虚线)。表演是指超过100集的平均累积奖励。灰带显示基于5,000个引导样本的68%CI。 g,超过100个情节的测试表现分布,显示智能体具有概泛化能力。到更大版本的球门环境,并在每个智能体的Tukey箱形图上覆盖一个小提琴图。 h,网格单元智能体的值函数作为热图投影到示例较大的门窗环境中(其中红色表示较高值的函数)。虚线表示原始培训环境的范围。尽管尺寸较大,但值函数显然会近似欧几里得距离目标的距离。 i,示意图显示基于矢量的目标导航所需的关

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[235952],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。